A Matemática das Redes Neurais

26.88k views9399 WordsCopy TextShare

Didática Tech

Nesse vídeo iremos mostrar a matemática que existe por trás do aprendizado das redes neurais. Curso ...

Video Transcript:

e fala pessoal sejam bem vindos a didática tec na hora de hoje a gente vai entrar um pouco mais a fundo da matemática das redes neurais para tentar entender um pouco maior como os cálculos são feitos baixo dos panos como é que a rede neural está aprendendo tá então a gente vai caminhar aqui pelo algoritmo de otimização das redes neurais venda matemática de ponta a ponta né de como são feitas as atualizações dos pesos da rede neural de maneira que ela vai ficando mais calibrado então é muito importante que já tem assistir do nosso vídeo

sobre introdução a redes neurais e depilar em destaque no canal das por acaso não assistiu esse vídeo é importante que já assista assista na mente de caiaque porque a gente vai usar aqui nesse vídeo já um último exemplo que a gente usou naquela aula onde eu mostro lá uma rede neural de duas camadas ocultas então aquele vídeo explico o aí eu sei se as vezes em horários uma abordagem intuitiva ea partir disso agora a gente tem problema parte matemática né inclusive lá eu procurei os a pouco a matemática para a gente poder deixar isso tudo

para eu e isso é muito importante já ter assistido aquele vídeo até entendido a essência das redes neurais né de uma forma intuitiva para agora poder avançar né para o próximo estágio que é ver a matemática além de como as vezes aprendem de fato usando os cálculos e outro vídeo importante que você já tenham assistido é o vídeo de gradiente descendente eu também já coloquei aqui no canal tá lá aquele vídeo lá eu explico com bastante detalhes o conceito de gradiente descendente a matemática hum gradiente descendente e aqui nesse ambiente vai usar aqueles conceitos de

gradiente descendente vou fazer uma breve revisão aqui tá para quem já assistiu já faz um tempo não se preocupa vou fazer uma breve revisão mas por acaso nunca viu falar de garantem excelente é bem importante que aquele vídeo porque aquilo preço pão será tem esse conhecimento eu vou só dar uma breve revisão não vou entrar em muitos detalhes sobre o gradiente descendente eu vou só mais aplicar ele mesmo aqui ao conceito de redes neurais tá certo então basicamente é importante é fundamental eu já tenha assistido o vídeo de redes neurais introdução as redes neurais abordagem

intuitiva é recomendado já tem assistido o vídeo gradiente descendente o importante é necessário também que já tem um conhecimento de derivadas parciais tá e também era da cadeia os conceitos básicos de cálculos derivados sabe o que é que a gente vai fazer muito muito a derivada é parcial e usando a regra da cadeia aqui para fazer as atualizações dos pesos é rede neural então se por acaso esse conceito está um pouco nublado para ti tu não conhece ou ainda esqueceu dá uma olhada de novo no rio de janeiro descendente que lá eu faço uma revisão

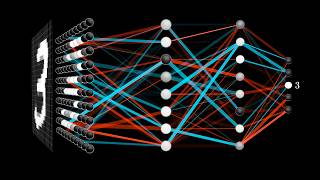

dos conceitos e também o nosso vídeo de derivadas parciais aqui no canal né onde eu também faço uma retomada nesse assunto tá então vamos conversar nessa aula tem muita coisa para gente cobrir nesse vídeo bom pessoal então só relembrando aula passada a gente tinha visto essa rede neural aqui aqui tinha duas camadas ocultas né uma camada de entrada onde os pixels de entrada estava por aqui por isso que eu já tá chamando aqui de e tá com o índice pé aqui o índice de cada um desses neurônios tá vai ser nada mais para representar aqui

por exemplo que entrada tenta e1 e2 e3 no caso eles são cada um dos 774 e aqui na primeira camada oculta da chamada de aquí mck no caso é o neurônio a1 a2 a3 até o neurônio a 30 né supondo que são trinta neurônios nessa camada e depois mais 30 gramas essa outra camada oculta eu tô chamando de ar com índice n e aqui eu tenho lá saindo com ele se jovem no caso é o s1 s2 s3 até o s10 são 10 dígitos de sair do zero até 19 tá lembrando aqui que um neurônio

que é mais ativado a gente é uma hora número né mas próximo de um cada um varia entre 0 e 1 barcelona que é costurada como a resposta ou seja um disco de resposta aqui da saída certo é que eu tô colocando os valores de w tá representando aqui os pesos né entre as camadas tá aqui alguns pesos wmj é porque estão os pesos entre a camada do ahan neurônios a ele até a camada sj por isso que os índices mj alguma coisa aqui ó os pesos da água km são dos neurônios a cá até

os valores hum e aqui wp eu quero ser olhos e p até os neurônios a acertam a gente vai retomar que essa figurinha volta algumas vezes aqui né menina que foi avançando na parte de matemática então a partir matemática ele tinha visto já que acabaram de sair daqui no caso né pode ser representado como sendo um somatório tá então aqui ó eu não somatório do coloquei aqui do lado é um somatório de todos os pesos wmj estão cada um esses pesos aqui cada uma das conexões não desenhei todas né mas é que você sabe que

cada um desses neurônios é vai ter um peso associado a cada usar de saída então todos nós vamos aqui a ficar maluco tu é a última camada oculta dessa rede estão tem um termo associado a cada uma dos neurônios é dos 10 neurônios de saída aí então aqui é um somatório de cada um esses pesos vezes cada um dos neurônios somados no final a um várias né a uma constante aqui isso vai usar o valor da saída de cada elemento é assim jovem então aqui por exemplo se eu colocasse o s 11 né no primeiro

neurônio zinho aqui ó por exemplo né seria a soma do w n e aí então cada wm aqui de casa neurônios né associados a esse neurônio um aqui a soma de todos esses pesos dados fez os neurônios aqui da camada a somada depois a uma constante aqui de um nessa ela esse nononi s1 - a saída s1 tá e depois vocês que saber a saída s2 terei fazer a mesma coisa só que dessa vez com os pesos ele wm-2 né sociados a esse drone aqui mas no final a constante b2 tá então dessa forma a

gente pode representar aqui já tinha visto na última aula só relembrando aqui né pode representar a saída de qualquer um dos olhos aqui né aí eu vou aplicasse imod em cima disso função sigmóide né que faça o que a saída de colocar entrada na esteja situado em fizeram então aplicar assim nós dentro dessa função zinha chamou de criar aqui e com isso que a gente vai ter agora nossa saída de verdade a gente vai variar entre 0 e 1 tá certo muito bem então isso a gente já sabe acertar o leque só camada de saída

né e a gente pode representar essa conta nessa equação a matricial também pode dizer aqui por exemplo era que essa saída né um vetor de saída no caso né sj ele seria representado por várias saídas aqui que seria a saída um a saída dois por exemplo né até a nossa saída s10 que a última eu gente saiu da minha essa conexão 10 neurônios saiu então isso aqui vai ser um retorno né vetor aqui ela é assim j tá eu também posso ter aqui é um outro retorno né que é o vetor dos neurônios a certo

não dá aqui nesse canto de fala o vetor dos neurônios ali vai da última camada oculta né ele vai ser o que nada mais do que os valores a1 e a2 até todas neurônios até um neurônio aqui a m né que é o último neurônio acabar o culto eu comentei né que tinha 30 neurose mas na verdade a quantidade de drogas aqui não importa tá poder comer torto a quantidade de nós vamos aqui não importa o que importa mesmo é saber né identificar claramente aqui quais são as variáveis que tem que eu tô aqui sem

os neurônios a e a gente pode criar uma crise dos neurônios dos pesos w tá então aqui vou colocar aqui no meio ó a matriz os pesos da água ela pode ser consumida seguinte forma a gente vai ter um peso w né que vai ser um peso dado tá na linha um acordo não vai ter um peso w que tá na linha 1 né na coluna 2 depois assim por diante né até chegar aqui um peso w que está lá na linha 1 na coluna e me tá e aqui mesma forma que faz tempo peso

w que tá na na linha 2 né aqui na coluna um tá aqui um peso w tá na linha 2 mas a coluna 2 e assim por diante é até aqui um w cavalinha dois na coluna e me e aqui também pode descer isso aqui né até chegar ao peso w que está localizado na linha j tá na coluna um depois a gente vai ter um peso w na linha j na coluna 2 assim por diante até um peso w é localizado na linha j na coluna hérnia tá então aqui né ainda dessa forma aqui

nessa matriz né a gente vai ter que uma matriz de pesos w tá então aquele conseguiu tem que ter essa matriz de pesos w tá associada né aquele neurônios de saída os alunos saída aí pode agora escrever até aqui ou botar os pesos o retorno dos pesos beira das constantes b j né que no caso aqui a gente pode não ser o b1 b2 e se né até o bj tá que a última constante ele saiu aqui você quer um outro eu tô dizendo que a gente tem né e agora a gente pode fazer uma

possa matricial aqui onde a saída né aqui ela vai ser representada como o a multiplicação aqui dos pesos da água da matriz de pesos w vezes a matriz ah tá mas e a construir a o vetor b tá então isso daqui né eu vou aplicar a função sigmore em cima disso daqui é uma pessoa assim ó ele vai que quer ficar em cima de cada um dos elementos aqui então agora estou usando só que tudo só uma crise só que vai ter uma matriz ainda está indo que mesmo não precisa saber de nilson nesse caso

aqui vai ser uma dimensão igual à quantidade de linhas de w e de colunas né de ar que uma multiplicação matricial e assim né ocorre o que é o primeiro elemento aqui né da linha um multiplica o primeiro alimento aqui dessa matriz depois vai ser esse vezes a segunda elementos da linha 2 de ar depois o próximo elemento da coluna aqui vezes o próximo a próxima linha de ar e assim por diante gente vai multiplicando ele onde estão as colunas aqui de w vezes elementos da linhas aqui da outra matriz tá aqui no caso aqui

no whatsapp tem somente uma coluna e a matriz resultante vai ser a culpa mas esse tem a quantidade de linhas de w e a quantidade de colunas de ar tá então aqui a gente vai ter uma resultante que a gente já sabe né que é apenas uma coluna tá então vai ser um retorno aqui de saída mas o que importa é que a gente a gente já tinha uma conta matricial né mas é uma criança que vezes um retorno mais um outro vetor eu vou ficar assim ó aí disse não é uma outra forma de

representar né esse caldo tá certo então na realidade a gente for olhar vários papers acadêmicos da geralmente eles representam de forma matricial estuda aqui entendeu só para entender é uma forma elegante de representar né e simples onde está colocando cada um dos pesos aqui né com respectivos índices que vão tá multiplicando aqui os outros neurônios estão aqui para quem já esqueceu aqui da figura né então só pra ver de novo a gente tem esse a matriz vetor aqui então esses neurônios aqui né aqui estamos pesos w né associados cada um deles é um neurônio mais

aflitivo a saída sj tá certo então muito bem já vimos aqui uma primeira introdução né o assunto agora a gente pode avançar um pouco mais para tentar descobrir como é que a gente pode fazer atualização dos pesos né também já calibrar nossa rede neural né isso que a gente queria nosso objetivo maior aqui nessa aula é conseguir fazer a embraiagem aqui né de cada um desses pesos e a gente tá vendo só a camada de saída né mas a gente vai ter uma conta dessa proximidade para cada uma das outras camadas aqui tá aqui na

camada de saída foram os pesos da meu mj * os neurônios hum né e isso resultou na saída sj nesse caso aquilo cada neurônio a ele vai ser resultado da multiplicação dos pesos wkm vezes esse neurônios a carro e aqui o cada um dos neurônios dakar resultado da matriz que multiplicam as entradas e pires aqui os pesos wpk tá então aqui eu só fiz uma representação né na verdade isso defende para cada uma das camadas da nossa rede neural aí também não deve calibrar então cada um dos pesos né tanta que os pesos w como

os pesos b como a gente já calibrar cada um deles na nossa rede neural para isso a gente vai criar a função de custo a gente chegou a ver um pouco disso né na última aula então a gente vai relembrar que nem o conceito do função de custo que é o que a nossa função de custo a gente vai definir é tô vendo a diminuição né o que você é um somatório vou tá aqui né da diminuição entre cada um dos alimentos de saída sj né pela referência que é o yj então aqui a referência

aquele valor que deveria ser e o essa é o valor que a nossa rede neural tá dizendo tá então lembrando né da última aula tava falando sobre a arte infantil das redes neurais eu comentei aqui em casa eu não sei se vai ter uma um valor que varia entre 0 e 1 né esse por exemplo a referência ou seja o gabarito né coloquei uma entrada aqui né que representa sobre os cinco então a referência y aqui no caso vai ser um neurônio 5 tá vale um e todos os outros valem certo tá eu vou comprar

a minha saída vai ter outro valor que não é exatamente iguais cada negócio vai ter um valor aqui e eu vou diminuir tá isso aqui era para ser 0 mas tá 0,35 então vai servir a 35 - eram né isso aqui vai ser elevado ao quadrado né que faltou colocar aqui essa opção de curso né ela tem aqui um quadrado aqui bom então eu vou levar essa parada eu vou fazer a mesma coisa para o próximo é mesmo e assim por diante de somar todos os dez alimentos aqui que eu tô chamando dj né cada

um dos alimentos derrota então aqui j ele varia de 1 até tá então tá cada um lembrando j tá vou somar aqui cada alimento mesmo a sua as respectivas referências né que é o motorzinho de que o nosso gabaritos para cada uma das entradas tomando sumiu se eu voltei a função de curso para cada uma das entradas tá certo então isso aqui é uma revisão da última aula nada de novo até aqui lá tem a minha saída fj ta a minha saída sj eu posso dizer que ela é o seguinte a minha saída sj né

como a gente já viu ali ela é o somatório né dos pesos wmj tá vezes os neurônios a m né mas uma constante de j para cada um de nós vamos sair e eu vou aplicar uma signoria em cima disso tudo né então fazendo assim olha isso aqui né quando ativação sigmoide em cima isso aqui eu vou ter nessa e pra facilitar aqui esse somatória sobre os pesos e mas não vou colocar aqui né e me que vai de 1 até ele para todos os as condições só colocar aqui numa pregação é somatório sobre os

índices cm aqui para facilitar então é que eu posso dizer que essa parte de dentro né vamos separar aqui já tem uma outra função aqui que vai igual a essa um dizer que essa parte de dentro essa função sigmóide ela é a minha variável é a cj que vem antes da seguir mostra uma chamar de sjc de nós dá para dizer que ela é a pressa e demora então ela foi sozinha é o somatório aqui mais as constantes b que eu vou colocar assim emoji para dar então até a saída esse j ou seja o

sj ele vai ser a sigmoid né da menina variável sj pressa ele mora aqui tá então só para facilitar depois dos cálculos aqui e também fazer algumas derivadas então então você que vai facilitar bastante pra gente então muito bem agora que ele já tem aqui a nossa variável de saída bem representado vem apaixonada a gente vai a gente pode começar a falar sobre a função e aí sobre o gradiente descendente tá então quem lembra da aula de gradiente descendente lá eu comentei tinha a função de custo né vamos ajudar quem tem um gráfico tá tem

um gráfico onde a função de custo né que tá replantando aqui pela o eixo vertical mas é função de custo e aqui o eixo horizontal é um peso w m tá então cada um do mj que botar o cada um esses valores wmj nessa executivo ações de curso vai ter alguma variação a partir desses valores da vmj tão magistral louro específica tô congelando apenas um valorzinho' um peso da rede ameaçam de curso ela vai ter uma representação será pode ser assim por exemplo né que vai variar a partir de com pontos que o marinho esse

valor wrj então para cada valor que ele pode assumir aqui estou fazendo a função de pulso ser maior ou menor tá tem um valor mínimo aqui que eu quero encontrar tá mas eu não sei com essa hora ainda então se eu aleatóriamente escolher qual que é o valor aqui para esse peso wmj vamos dizer que eu tô aqui ah tá então escolher atualmente o valor aqui eu caí nesse ponto aqui tá específico um valor wmj e ele esse volume dado um valor da função de pulso tá certo se eu variar esse rolando um pouquinho para

cá aqui no caso pouquinho pra esquerda eu sei que não é função de pulso vai diminuir né então é bom isso eu quero dar para cá e se eu mandar para cá elevação de portugal não tá então eu quero ajudar a diminuir o que rolou de wrj não quero mandar ele para cá vai até chegar nesse valor de mim não tá eu vou lugar por aqui tá eu só fazer uma reeducação aleatórias em poder estar em qualquer lugar a gente então aqui como é que eu vou saber se eu tenho que variar o meu peso

wmj para cima ou para baixo para isso se eu fizer a derivada né se eu fizer aqui a derivada da função de custo em relação né brigada para relação de custo em relação ao peso da água mj eu vou saber a taxa de várias todas a função de custo em relação a esse peso tá então aqui a taxa de variação vai tomar a regra aqui mais ou menos na localizada nesse ponto tá que vai a taxa de um ângulo aqui no caso essa reta vai me dar a taxa de variação da função o povo tá

eu não gostei musicais aqui porque na aula do descendente já expliquei aqui com mais detalhes né daqui só para relembrar o conceito quanto mais distante a gente tá aqui né mas maior é a função de curso não vou mais na criação de curso aumento aqui né e tal e já era um ponto aqui a metade variação mais um pouco mais inclinada aqui né mas para tirar essa vai ser maior quanto mais fácil não tiver mais ele tem nada vai passar ela seja maior vai ser a taxa de variação para o outro lado quanto mais pra

cá eu tiver né mas perto do mínimo aqui mas o deus é um pau vai tá minha taxa de variação ou seja menor vai ser metade de variação menor vai ser o valor dessa derivada aqui então quer dizer que quando essas derivadas aqui é grande tal valor da derivada é algo que eu sei que eu tô longe do meu o valor de mínimo que ela onde eu quero chegar e como esse valor aqui é pequena caseiro eu tô perto do mínimos eu quero chegar tá então pode ser uma boa estratégia eu fazer a atualização dos

meus pesos então vamos lá aqui que eu tenho o meu wmj ele vai ser atualizado tá na interação aí eu tenho uma atualização específica aqui né uma interação de número ii onde a cidade dj ele vai receber que o valor que vai ser o mj anterior que ele tinha antes tá então é da interação e menos um tá aí menos um a iteração anterior isso aqui vai ser subtraído aqui tá de um valor da uma constante que a taxa de aprendizado que multiplica então a nossa derivada parcial da função de custo em relação ao peso

wmj só para relembrar a alta qualidade excelente qual é a loja aqui da coisa é simples ó eu tinha um valor ético escolher até mesmo tempo na primeira geração tá e tratam zé então aqui na internet a primeira geração a gente tem um wmj tá inicial aleatório onde na próxima iteração ou seja o wmj aqui da interação uma é a próxima interação vai receber iteração anterior não rolou criatório vai ser atualizado né você reduzido aqui para o valor que é proporcional a derivada aqui da função de custo em relação a esse peso então vocês vão

que for grandes elevada flor grande quer dizer que eu vou dar um grande salto aqui tá você atualizado meu w aqui né final aqui vai ser atualizado para o valor grande afinal e aí você ganha eu tô muito longe isso eu tô perto de volume mínimo esse número aqui vai ser atualizado por um valor pequeno por esse valor aqui vai ser pequeno derivada desse cara aqui né mas ser pequeno para tomar os preços do milho então essa é a pontinha que faça o quê para cada iteração então achar o melhor valores de w aqui né

eu vou dando passos que são proporcionais algum instante eu tô do valor mínimo né então se a gente foi lá na loja para ver se esse mês é mês depois a gente vai fazer aqui dá para atualizar cada um desses pesos wmj lembrando que tá falando aqui dessa camada aqui cada um esse pezinho da bíblia joga aqui relacionados a camada de saída tá então eu vou ter que fazer essa conta vou ter que fazer a derivada da função de custo que eu já encontrei aqui com essa opção de curso é essa daqui ó eu vou

ter que ver e vai isso aqui em relação aos duas peças wmj e hoje é que tá no meus pesos wj eles estão aqui ó eles estão dentro da minha variável é assim dj tá então eu tenho que fazer aqui agora eu tenho que fazer a derivada parcial tá do que encontrar aqui qual é o valor da aqui no canto ó qual o valor da derivada parcial da função de custo em relação ao a deus wmj tá qual o valor da saudade dessa derivada aqui tá peguei o valor do monnerat né da nossa constante aqui

taxa aprendizagem mas não rolou constante tá é isso aqui vai ser o valor anterior nossa interação então o valor realmente preciso calcular esse aqui tá que a derivada ações de continuação aos pesos dados então como é que ele vai fazer levado essa derivada ela vai ser igual ao seguinte ó vai eu posso dizer que a derivada parcial da nossa função aqui é assim dj tá aí vai passar lá para o som festa dj que multiplica a derivada parcial da função da variável sj em relação a nossa variável de interesse que é o wmj todos aqui

eu tô fazendo a regra da cadeia tá lá na loja da nesse cedente ou eu faço uma previsão da regra da cadeia é porque quem tem duas funções a tem uma função de custo né eu tô derivando em relação super usável mas a função de custo ela tem uma variável aqui que é a variável sj e deu trabalhado sj existe a nossa variável de interesse que aos presos dados bom então aqui eu vou derivada de uma função de custo em relação aos pesos dados em que derivar a função de conta em relação a variáveis j

e multiplicar esse pela derivada parcial da variável fj e relação ao wmj tá então eu fiz a revelar cadeia tá para chegar nesse resultado e por sua vez essa derivada parcial aqui ó ela também a gente pode fazer uma outra regra da cadeia nela a gente pode fazer ela sendo a derivada parcial da variável sj em relação a variável sj cima né veja a derivada parcial da sj cima em relação a derivada parcial agora assim os nossos pelo cnj tá porque porque quem tem duas funções também a nossa variável sj aqui ó ela também tem

uma função aqui cima tá que tá aqui nesse caso aqui é possível não consegui nós né foi pensando aqui para verdadeiro assim eu tenho uma função aqui externa que tá englobando assim daqui então de novo de fazer uma derivada parcial aqui tá uma regra deles culpa em relação a essa derivada aqui essa derivada parcial vai e aí agora assim que eu chegar no nosso longe interesse tá eu quem é esse cara aqui ó quem é a derivada parcial da variável sj em relação à sjc mann é bem simples essa aqui nada mais é do que

a derivada parcial da parafunção né sigmoide ali em relação a variável essa j5 tá tô aqui na tia não vai apresentar alguns detalhes aqui em derivação de nós sai até porque faz tem outras opções ativação tem uma pessoa que ele mais não só representar que a derivada da função morde em relação a nossa variável aqui né dj cima já eles ficaram aqui a gente já pode calcular ok a derivada da função sj5 que é esse cara aqui ó em relação aos pesos wmj horas pelos darlene j estão multiplicando aqui né as variáveis a ele tá

então a derivadas da dessa função em relação aos pesos wmj vão ser nada mais é do que o somatório aqui dos meus das variáveis aqui a m tá o somatório é sobre o índice n1 é feito isso porque aqui eu tenho tomando umas constantes então a derivada de sua akira em relação à da vai dar esse aqui vai dar certo né porque tá somando uma constante e esquecer como estava explicando essa variável de interesse né que eu tô alinhando então vai sobrar só que a constante que multiplica essa única coisa que eu tô variando aqui

né então esse aqui ela conceito de derivada né porque não conhece né recomendo ver os vídeos né aqui do canal são os assuntos então diabo já descobriu que esses dois termos é para tu só vai encontrar esse daqui tá então quem é esse cara aqui ó que a gente vai ser a derivada da função de culto em relação ao s j né variável sdj isso aqui vai ser esse mente essa equação aqui então eu poder levar esse cara aqui em relação a esse sj para derivar esse cara aqui eu posso fazer uma regra da cadeia

também que eu vou fazer a derivada da função de fora né que vai ser duas vezes o somatório ali ds dj - ygj na mão dele ver que eu voltar o pai dela para ir para frente né multiplicada pela derivada de dentro do carro assim então vai ser um então isso aqui é derivado ação depois relação ao stj vai dar isso daqui bom dia com todas as derivadas tem que precisava então é só vai escrever aqui no cantinho né para deixar essa equação aqui bem clara então aqui a nossa derivada da função de custo em

relação ao nossos pesos wmj relação aos dados mj vão ser aqui a derivada da função de culto em relação sj gente descobriu que é duas vezes né o somatório de sdj menos y dj tá tá multiplicar o stj em relação ao sjc rima né que a gente encontrou que é a seguir mostra que é derivado assim que morde em relação a essa j sim o que ela seu passeio vamos escrever aqui é o somatório do wmj multiplicar m mas o bebê dj tá certo então você que a parte de dentro ali né a função sj

cima agora tendo isso aqui faltou só a última parcela lá que é derivado do oeste já passei uma relação ao w e foi o resultado diogo somatório nessa do icm da asus vai das variáveis a lilian dos neurônios a m aqui é um somatório né sobre o índice j aí aqui também é sobre esse é beleza então aqui essa aqui nossa equação final tá botando espinho aqui ó essa aqui é a nossa equação final então que a derivação de funções relação aos pelo sábio tá então vamos pensar um pouquinho tá talvez nem seja meio confuso

posto tá não entendia que a equação foi feita assim que significa na prática tá o que se pode concluir aqui explica a gente pode fazer mas pode-se concluir que a variação de custo em relação a nossa variável zinha dar o nosso pesos w vai ser proporcional tá a o erro né foi calculada que a o erro a comparação entre a saída não que o que a foi uma previsão nossa rede neural em relação ao gabarito né ao valor real e que vai multiplicar aqui no caso né ainda cada um dos pesos vezes neurônios anteriores tá

e aí vamos ficar os interiores mais uma vez aqui ó então essa nossa saída variação noção de cozinha é nada é preciso tanto do erro como também dos pesos e dos neurônios acabar anterior tá então aqui é até a dependência né a gente tem aqui para atualização desses pesos tá então é a primeira passou a gente encontrou a gente poder também aqui e encontrar a nossa derivadas opção de curso né em relação a nossa outra variável que são os pesos de né os pesos ver aqui no caso j quem vai ter ficado mais até mais

fácil aqui ó porque a elevação de custo né em relação aqui nesse canto de carro tem espacinho aqui a elevação de culto em relação aos pesos b ela vai ficar o pular a como mesmo nem sair daqui você derivada né da nossa função de custo em relação ao a variável sj né que multiplica aqui a derivada dor é a sj em relação ao sjc em cima né porque afinal o bebê tá lá dentro né mas vai fazer que a menina falou que o w e também tá dentro desse acima vezes aqui a derivada parcial do

sj sigma em relação aqui a nossa ah tá então a mesma coisa que esse aqui vai ter que eu te levo negação a bebê se eu fizer isso esse cara já encontram nessa quanto é que é ele aqui em família sabe para que é só isso aqui que não encontrou então em vez de se desse caras essa aqui que a gente encontrou ele vai ser um encontrar ele aqui ó a derivada dessa função f j assim ó aqui em relação a ver vai ser um né então canal explicando vir aqui então ele vai tava com

mais grossa assim uma relação bem vai ser um então esse cara aqui é um tá então a multiplicação aqui isso aqui vai multiplicar um tá então ele já sabe que é ele resultado aqui ó até aqui né e certo esse termo último aqui vai multiplicar um final então a gente vai ter que ir esse resultado aqui ó vai ser meu sabão líquido em cima né ah tá então aqui a gente tem a nossa equação zinho da dele variação de custo em relação aberta então essa aqui é a nossa nossa outra forma que a gente encontrou

então agora a gente já sabem como atualizar os pesos da água e também já sabe como atualizar os pesos de né os pesos beijo aceleração aí você atualizar o da mesa fora com os seus pesos bj da interação e menos um é menos aqui a taxa de aprendizado né verdade ele variação de custo em relação aos nossos b tá então os pesos vez você atualizado com eles se afastam onde essa importante a encontrou-se derivado aqui mas sem nada por esse daí passamos vim aqui e cada um desses valores todos até passando em cima com lá

debaixo ele já tem esses valorização dados né então a gente pode a gente for escrever um algoritmo né no computador para realizar essa esse cálculo aqui vai ser simples porque todas essas variáveis aqui ó tá ele já estão dados estão ele já tem aqui esse valor já foram previsão em já vai ter na interação no interior ele já tem os olhos dos pesos anteriores né e tudo isso aqui da penetração vai ser usada para calcular a próxima interação bom então andei na mesma forma alto a próxima interação da futura também vai ser calculada dessa forma

com base no valor relação anterior tá então todas as flores aqui são representados os pesos né de uma mesa interação então todas as flores aqui são referentes a uma mesma interação da mesma forma que esse daqui no caso o cálculo de baixo também todas as hemorroidas equação assim são referentes a uma mesma geração tá então a quem já sabe como calcular depois a escrever um algoritmo já vai fazer esse cálculo para mim se ele quisesse perguntar isso no computador já tá tudo prontinho aqui dessa exatamente né como assim o resultado essas derivadas aqui a fórmula

tá certo então muito bem já encontramos aqui ó acho que a gente faz aqui agora a gente encontrou aqui como como saber como atualizar os valores do peso wmj que ele dessa primeira parte aqui agora você descobrir como ele vai analisar esses outros pesos aqui nessas outras camadas será que vai ser algo semelhante né vamos tentar descobrir isso aqui então agora a gente quer fazer é atualizar aqui descobri também já foi atualizar os pesos wkm tá que estão aqui entre a camada a cá e acabará em mente a saiu dessa parte aqui agora vamos ver

essa parte aqui tá ah tá se você exatamente igual isso aqui tá gente vai fazer uma atualização de cada peso vai receber o peso anterior né diminuído ali por uma constante e que multiplica a derivada desta função de custo em relação espesso na mesma coisa a gente fez aqui aí vai fazer aqui tá então o que tem que fazer é encontrar aqui né qual é a derivada da função de custo em relação aos pesos wkl tá na hora já tá descobrir isso daqui quem é esse cara tá para eles em descobrir quem é a m

né quem são os neurônios hum tá usando ônibus saiu da gente já sabia que ela não tinha feito o caldo ali assim são os neurônios a entre os neurônios da n eles vão ser o somatório tá dos pesos wkm se multiplicam os neurônios a cá somados as constantes b&m tá e eu vou colocar a sigmoid em cima de tudo isso né aplicando assim de emoji nessa posição aqui a gente vai ter as saídas aí ele tava no comparativo está certo isso só olha as saídas a ele é os neurônios a ele aqui é o resultado

da multiplicação dos neurônios a pelos pesos wkm somadas as constantes aqui b uma facada no lugar e me tá e apertando assim mais em cima disso beleza então tá certo tinha aqui encontramos equação a gente pode aqui né fazer a mesma coisa que a gente fez ainda vão dizer que esse tema aqui de dentro ó ele vai ser o nosso a ele cima tá aqui é o nosso neurônio a antes da não sei ficaram sangue morte tá certo então aqui né gente sabe que a nossa variável a m ela é a função sigmóide da minha

variável a ele cima tá mesma coisa a gente fez antes beleza então muito bem agora vou fazendo mesma coisa que nós vamos descobrir que o volante derivado quando ele variação de custo em relação aqui aos pesos wkm vão ser iguais a derivada da função de custo em relação a variável sj tá aqui lembrando ta que a nossa variável sg o trabalho anterior moto pagar você jogar camada anterior a gente viu a noção de custo ó ela depende da variável sj certo dentro da função da variável sj a gente tem aqui a variável a n e

deusa da variável aí ele é onde a gente tá agora deus trabalhar viu aí ele é que existe o peso wkm tá então peso wkm ele tá dentro de um monte de variáveis a e por isso ele tem fazer várias derivadas parciais aqui ó a gente vai ter que levar parcelas de cozinha em relação a variável sj depois a derivada parcial da força da variável stj em relação a variável sj cima tá porque a rayane tá lá dentro aí eu vou fazer a derivada da sj sigma em relação ao hm tá e dentro do aeme

agora a gente tem o quê aí pode fazer derivada parcial do hã-hã-hãe em relação ao n sigma é né e por sua vez agora sim finalmente a derivada parcial do aeme sigma em relação ao nosso peso wkm tá pagando todas as parcelas que não tem funções dentro de nós vemos as outras né então aqui uma última vez no monte molhado ó o nossa o função de curso dentro da função de custo tem a variável sj ver o da variável sj né a gente tem que voltar aqui ó ele trabalhar nesse j a gente tem o

nosso jornal n e dentro do nosso neurônio ele a gente tem a função a mc rima e deus vai funcionar n sigma a gente tem a nossa o pezinho de wkm tá agora sente tati ficou aquele cada uma das funções entre outras funções eu poderia aceitar o nosso cabo das derivadas tá porque esse cara aqui ó a grande variação de custo em relação ao stj a indireta sabe quanto é calculou essa derivada aqui do stj em relação as outras aqui mais também já calculou esse cara que a gente não calculou aí vamos ver quem é

esse cara que a derivada da eu tenho em relação ao hm tá esse cara aqui ó ele vai ser o somatório né que quem não lembro ali do da copa anterior mas é o somatório do wmj tá em relação aqui ausente se sentavam lembrar aqui ó é que eu tô derivando sj5 em relação à emissão ver aqui ó a derivada do stj cima em relação ao a m que é que tava explicando o que é o wmj então por isso aqui que vai ficar né o somatório da vmj ali né como resultado da casa dele

vai aqui tá então aqui feito isso a gente pode fazer agora a derivada parcial do a m relação ao euro e cima né aqui também da forma que a gente fez antes de levantar esse aqui como chama a derivada né da seguir morde em relação a nossa variável aqui aí me cima tá e esse cara que a derivado do aeme cima em relação ao wkm vai ser o cara que multiplica ali os wkm que são as variáveis a carta somatório isso aqui sobre os índios ah tá então aqui a gente tem o caldo todas as

derivadas a gente já encontrou tá então vamos representar isso aqui colocar tudo na equação só vou colocar aqui no cantinho tomara que eles passa um verdadeiro vai aparecer audi da opção de curso em relação aos pesos wkm vão ser iguais a esse cara aquele variação de custo em relação ao stj a gente já calculou já sabem que é duas vezes é o somatório do nosso sj - o yj tá que já foi feito depois o próximo cara ali vai ser a derivada da o sigma em relação a função de dentro né que era o somatório

dos dablius nj né tem um levar só pode pausar o vídeo ali e voltar né wmj vezes a amy mas veja o ato oi tá aí aqui depois o próximo elemento ali a gente já calculou aqui né que é o somatório duas wmj depois vou explicar aqui a nossa seguir mole né derivada dela em relação ao hemisfério há quem largue esse é o somatório em cima lá dos pesos wkm vezes acabar mais bl na e agora o último elemento ali é a um somatório dos aqui ó ah tá então você quer sobre sua casa quer

sobre os índios e me esse aqui é sobre os índices m eu sei que também assim desse cm tá eu sei que o suficiente cj tá depois eu para derrotar o se você vai ficar muito chato já mas aqui então a gente encontrou nossa equação final aqui né voltar uma estrela para a derivada ações de custo em relação aos pesados km tá foi encontrado aqui então para cada iteração é só substituir que todos os olhos já estão calculado interação interior né só subir todos eles aqui dessa forma e encontramos a forma de atualizar os pesos

wkm tá e da mesma forma para encontrar os de variação de custo em relação aos nossos valores b da bm mas tem a mesma coisa aqui né vai ter que ser o mesmo carro todo derivadas parciais aqui aqui no final em vez de derivar em relação a w né a gente vai tirar esse cara aqui vai derivar em relação ao bebê que vai dar um então esse último elemento aqui não mais existir tá então vai ser toda essa esse cara aqui ó até esse ponto aqui tá então vou botar aqui embaixo eu tô aqui encontramos

a nossa equação para atualizar os pesos b beleza muito bem então agora o que que falta ao calcular aqui faltou encontrar agora a nossas atualizações para os pesos w&b que relacionado a nossa camada de entrada e a nossas camadas aqui a cá tá certo deu para ver já que essa equação aqui ficou bem maior do que a equação anterior a equação anterior que a comparando ficou desse tamanho e agora nossa outra camada que fica um pouco maior ó adicionou alguns temos aqui será que você vai continuar aumentando a sala essa loja nessa a gente vai

agora do cálculo da próxima camada também vai ter uma equação maior vamos descobrir aqui ó vamos começar calcular agora então a nossa próxima camada que vai ser aqui a camada da entrada em relação aos nossos pesos ali ipe tá e vamos ver aqui que pelo só é são os dados pecar então eu quero atualizar aqui dessa vez os pesos wpk tá então quero descobrir aqui né em outras palavras qual é o e da nossa de variação de custo em relação aos pesos wpk tá quem é esse cara aqui bom antes que a classe derivada tem

que saber quem são os nossos neurônios a carne né olha eu não esqueçamos isso quem aulas quem são nossos grandes a ele não ser o somatório tá dos nossos pesos de entrada wpk que multiplica o nosso neurônios entrada né que você o seu mundo agp e isso aqui vão somar nossas variáveis constantes b cá né relacionadas aos neurônios a cá isso aqui também vai ficar sigmod isso aqui né então tem a opção sim emoji aqui aplicada nisso tudo então esse aqui vão ser o valor é nós estamos a cara aqui ó o sono sacar para

unificação dos pesos das vezes as entradas né mas a constantes vir aqui beleza então agora a gente vai fazendo isso vou fazer a mesma coisa né mesmo procedimento vamos chamar esse cara de dentro aqui ó de aqui em cima tá e agora que a gente já tem ele representar em pó a fazer a brincadeira de lado parciais então vamos ver como é que vai ficar aqui essa derivada parcial em relação aos pesos dar eu perca eles vão ser a derivada é um lembrar lá nada início então lembrar ele variação de custo em relação a variável

sj certo depois eu tenho muito ficar a variável sj em relação ao sjc e mané que a significação do stj lá daí dentro dela existe o que dentro delas trata cima existem nós os nossos neurônios neto a m certo nacional e entra dentro dessa jcm e dentro neurônio a m né existe um neurônio o whats aí ele cima tá dentro do seu olho a m sigma não existe os neurônios a cá né que estão esse a gente está calculando tá vou ver se é isso mesmo aqui a gente tava aqui nesse ponto né então dentro

da m cima que tá loca tá então então não é eles não emitem live senhor dentro da mc gui mantém o a cartão beleza tá certo aqui também tá fazendo agora aqui então a gente vai fazer o que faltou agora fazer a derivada parcial do nosso lá tá em relação ao a cá cima né e agora sim a derivada do arco acima em relação ao nossos pesos né wpk então agora sente concluiu aqui né toda a nossa derivada parcial né toda a tripa aqui vamos ver né dessa derivada parcial em relação aos pesos w pecar

tá certo então beleza até aqui ó e ficarem já fez esse aqui já fez esse aqui a gente já fez anteriormente já né esse aqui a gente já fez também né e aí me seguiu esse aqui o mc em relação a carne ainda não fez tá que é melhor da parcela do aí eu em cima em relação a cá então quem é a derivada parcial aqui não voltar aqui a derivada parcial do aeme sigma desse cara aqui ó relação acaba seu somatória dos lábios cayenne então aqui esse cara aqui vai ser nada mais do que

o somatório nos pesos wkm tá então você que tá fácil calcular esse cara aqui aquelas a derivada parcial do acai relação a cá cima mas tem algum de sair de casa aqui na comida sempre fez as elevadas que morre ali em relação ao a cima tá e esse cara aqui vai ser a derivada desse aqui olha dessa parte de dentro em relação ao dado apk depois nada mais é que o somatório dos pp né o somatório das variáveis e p tá então agora a gente pode representar isso aqui tudo no meu coração só a gente

vai ter aqui então e quando nascerem variação de custo em relação ao wpk vai ser igual ao mesmo tempo em que a derivada do fundo de poço em relação sj né quem quiser voltar o vídeo ali né e lembrando vai ser duas vezes o somatório né do sj - wilson j aí o próximo tema elevado sj em relação a gente já tá cima era a derivada né da sigma em relação a primeira camada que era o somatório dos pesos wmj vesaire usando some né mas agora sim os nossos constantes dj e daí depois o próximo

tema ali né a derivada do extra fazendo em relação ao a ele era o somatório dos pesos né wmj aí depois o próximo treino que a derivada do ar em relação ao m sigma era a derivada né assim mod da próxima camada que no caso é os pesos wkm né é a próxima vezes e mais os b&m tá aí agora sim entramos aqui já nessa nova linha que nós calculamos que o próximo tem não vai ser o somatório de wkm depois o próximo termo é a seguir morde lei válida sigmoide do a cá cima onde

o a cá cima é o somatório do wp cartão em cima da eu pecar vzp é mas bk tava caber tudo tá agora é o último tempo que é o somatório de p né das dos neurônios vp de entrada pronto come tudo aqui ufa tá aqui então toda nossa equação né que a derivada da função de custo em relação aos pesos wpk então aguarde mais uma vez a cada iteração bastaria ser um escritor os valores de entrada na legislação anterior aqui nessa equação a gente teria o resultado então para atualizar o peso da apk e

da mesma forma é só botar aqui embaixo rapidinho aqui a derivada é um som de custo em relação aos nossos baias né são os baias do índice cá bom então aqui vai ter e para que eu faço amei tudo né é só recuperar que desculpa todos os esses valores aqui onde aqui no caso a última derivada né que foi derivado do acácio em relação ao wpk em vez de ser ver aqui eu vou derivar o a cafeína em relação ao bk né então aqui derivando em relação ao metal e dá um então essa derivada aqui

vai dar um então não tem ep aqui dentro só x 1 aqui então aqui a gente tem na outra e passam atualizar os pesos em relação aos constantes bebê então tá pronta gente conseguiu aqui derivar nele todas as equações para atualizar nosso pesos e barras e toda nossa rede neural tá lembrando aqui né que lá no na primeira camada né gente fez a gente que tava visualizando com um de forma matricial né então enviou essa rede neural aqui essa parte que ele foi matricial e cada uma dessas camadas também pode ser visto de forma parcial

ou de cada um dos pesos né e baias dessa matriz né de carão nas camadas várias receber seus respectivos atualizações né com base nessas equações funções sempre foi comparar as equações umas com as outras né é mas pode chegar à conclusão aqui por exemplo né que essa equação a equação dos pesos de entrada né olha o tamanho dela é muito grande aqui que significa isso significa que a variação da função de custo em relação aos peso de entrada né ela é uma variação a que depende tanto do erro né da saída como também dos pesos

da primeira à última camada ali os pesos da da próxima camada e os pesos da camada de entrada então a variação da função de custo em relação aos pesos de entrada eles depende de todos os dados todas as constantes toda rede neural é isso é muito interessante você falou que você vai rede neural porque a gente atualiza um peso aqui ó um pezinho a esse aqui por exemplo aqui vai ver se neurônio para esse aqui ó tem que mexe nesse peso a gente está mexendo nesse meu nome aqui sério só que esse número aqui tá

mandando informação para todos os neurônios a próxima camada então quando a gente mexe nesse peso aqui é um pesinho só tá essa linha aqui ó aí está mexendo em toda essa camada da rede neural aqui ó porque a senhora não manda informação para todas as bom e cada um desses por sua vez manda para toda essa então uma alteração aqui ó tem uma alteração desse neurônio tem uma alteração aqui em todas essas camadas e uma outra alteração ainda maiores lança ainda né afinal já mexeu aqui e cada um deles contribui para a saída então alteração

aqui tem uma implicação aqui nesse cara que não foi tão grande depois a gente ficar só nesse cara para essa camada foi pouco melhor afinal ensinando é que mandou e fumaça todas as camadas e as camadas que foi mais impactado ainda né porque cada um deles também enviou para cá então uma alteração aqui passa em toda a rede neural até o final enquanto a alteração desse peso aqui tá operando só que não é direto não falei que é muito interessante observar se pode concluir isso né as equações vamos mostrando uma coisa que intuitivamente podia imaginar

ele olhando com a rede neural na pensando na aula anterior mas poderia já ter sensibilidade mas aqui é matemática nos mostrou né que de fato quando a gente faz uma mexe mexe um pouquinho esse peso né a nossa função de curso vai ser alterada com base em todos os valores né das camadas até hoje a tela então essa aqui é o ensaio o prejuízo se eu tivesse né ao analisar aqui a praça-forte de matemática aqui de como atualizar esses pesos né então agora que ele fez isso conseguiu visualizar este informativo fiscal também ele pode dizer

que a nossa missão aqui e vera matemática por causa das redes neurais ela já está concluída então pessoal para ter acompanhou a aula até aqui primeiramente o meus parabéns é raro ver alunos querendo entender a essência das coisas preocupado não apenas a parte prática da programação e ver resultados mas também queria entender como os amigos funções por baixo dos panos com abordagem matemática ele que cálculos que são feitos então não pensa interesse né que os vem esse vídeo aqui com calma os parabéns é um sinal de que provavelmente vai se tornar um ótimo profissional de

uma churn ciência de dados se tu gostou da nossa abordagem né gostou da forma que a gente ensina ele a nossa preocupação em explicar esse com 61 deixe de conferir todos os nossos cursos né aqui na descrição do vídeo vou deixar um limpa e tu posta ali navegar pelo nosso site conheça os nossos cursos e também não deixe de se inscrever no nosso canal que a gente vai continuar postando vários conteúdos aqui é muito próximo vídeo dessa série que a gente começou de redes neurais deep lane vai ser o vídeo de gradiente descendente estocástico é

um vídeo também muito importante fundamental para quem que é sempre abençoar nessa área de redes neurais e vai ser uma continuação daquele no primeiro 20 começou né sobre a gente descendente depois agora a gente já conhece como vai dizer excelente se aplica às vezes o horário a gente já pode entender para quê que existe qual é a essência por trás do gradiente descendente e os tocasse o que é na realidade o a essência de um dos algoritmos de otimização mais usados nas redes certo a gente se ver já no próximo vídeo até mais [Música]

Related Videos

14:03

Gradiente Descendente Estocástico (Otimiza...

Didática Tech

12,292 views

1:06:32

Introdução a Redes Neurais e Deep Learning

Didática Tech

90,163 views

51:09

A matemática do Gradiente Descendente & Re...

Didática Tech

59,278 views

1:04:05

Cientista de Dados do ZERO ao AVANÇADO em ...

Didática Tech

11,639 views

18:40

But what is a neural network? | Deep learn...

3Blue1Brown

17,861,583 views

17:23

Aprenda Redes Neurais Com Python - Treinan...

Inteligência Mil Grau

19,636 views

26:34

Crie uma rede neural com apenas 5 linhas d...

Didática Tech

26,328 views

41:33

Árvore de decisão - Como funciona (Machine...

Didática Tech

75,388 views

1:30:57

Aprenda a programar do zero com ChatGPT

Didática Tech

29,650 views

![Aulão de Aprendizado por Reforço [Teoria e Prática!]](https://img.youtube.com/vi/Bn6kIArpd3Q/mqdefault.jpg)

1:33:20

Aulão de Aprendizado por Reforço [Teoria e...

Didática Tech

8,953 views

1:09:58

MIT Introduction to Deep Learning | 6.S191

Alexander Amini

733,505 views

42:54

Redes neurais e multilayer perceptron - Au...

Diogo Cortiz

17,260 views

46:24

Cálculo (AULA 2): Derivada

Didática Tech

12,832 views

48:17

Fazendo uma Rede Neural do Zero! #1 - Feed...

José Bezerra

293,370 views

20:01

Rede Neural aprendendo a jogar o jogo da c...

Universo Programado

826,889 views

13:55

O que são Redes Neurais e Deep Learning

Hashtag Programação

18,178 views

28:57

Seu primeiro código de Machine Learning co...

Didática Tech

107,475 views

29:58

Construa um neurônio artificial do zero. E...

Prof Francisco Calaça

30,265 views

28:11

LSTM

Rodrigo Guerra

5,506 views

57:11

Deep Learning - L14 Redes neurais recorren...

Dalcimar Casanova

1,295 views