Redes Neurais: Visão geral do treinamento de MultiLayer Perceptron (MLP) com o Backpropagation

2.77k views1707 WordsCopy TextShare

Fernando dos Santos

O Backpropagation é um algoritmo para treinamento de redes MultiLayer Perceptron (MLP). Ele faz com ...

Video Transcript:

e ele vai ter que treinar a nossa rede esse treinamento é aquele processo de ajuste de pesos que você já viram como é que tem funciona no percebe Num simples de uma única camada esse algoritmo de treinamento e recebe o nome né o nome não é mais aprendizado Delta o assim uma generalização desse aprendizado Delta porque agora ele tem que lidar com várias camadas e ele tem esse nome aqui ó deck propagation esse beck não é de propósito porque agora a propagação né o ajuste dos pesos ela vai começar aqui no final e vai voltando

na sua rede Então você vai calcular os erros aqui na saída né com base nesses erros você vai atualizar os pesos da camada de sair atualizando os pesos da camada de saída depois você retrô propaga faz mais um passo Beck né para atualizar os pesos dessa Ah e assim vai você vai retrô pagando essa atualização dos pesos para cada uma das camadas que você tem na sua rede certo então esse esse ajuste de pesos ele acontece desde a camada de saída até todas as camadas ocultas sempre desse modo sequencial sempre voltando aqui né fazendo a

a retropropagação do ajuste dos pesos e para cada uma dessas camadas aqui você vai aplicar uma daquelas formas de atualização de peso muito parecidas com aquela quê que vocês fizeram do perceptron elementarno prezado dela aqui no próximo slide eu mostro para vocês como que é a estrutura né o seu do código deste algoritmo backpropagation dois semestres anteriores as O que é uma execução passo a passo para eu demonstrar para outra turma como é que isso aqui funcionava nesse semestre eu optei optar por não fazer essa demonstração passo-a-passo até porque ela é bem trabalhosa né Vocês

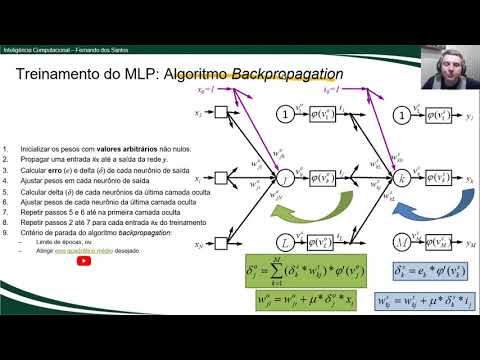

imaginam multiplica aquela aquela propagação simples que vocês fizeram lá no exercício para cada uma das camadas ocultas e para cada neurônio desce de cada uma daquelas camadas ocultas então é bem trabalhoso eu vou passar só em linhas Gerais como é que funciona para que vocês tenham ciência de tudo que está envolvido aí não o treinamento da sua rede das suas diversas camadas estão aqui a gente tem o pseudocódigo deste algoritmo né A primeira coisa primeira diferença em relação ao treinamento pelo aprendizado Delta é que agora todos os valores de peso w Lá Da sua rede

todos são inicializadas com valores aleatórios o valores arbitrários não nulos essa é a primeira diferença é aquele treinamento anterior que sempre começava a 10 que que acontece em seguida acontece aquela mesma etapa de propagação das entradas de cada uma das entradas x até chegar lá na saída Y nas saídas Y Da sua rede uma vez que você tenha saída Y você vai calcular o erro esse erro não é a diferença do resultado desejado para o resultado obtido e esse erro vai te dar um valor Delta bom né é esse valor Delta é o valor que

você vai usar para ajustar os neurônios da camada de os pesos dos neurônios da camada de saída olhando aqui no nosso esquema dois vamos olhar para esse por exemplo este único neurônio aqui e essa rotina se aplica com os mesmos para qualquer outro neurônio dessa camada oculta então eu coloquei numa certa Azul essas duas etapas aqui de atualização de peso então a primeira etapa é depois que você calculou né o valor Y é você calcular o valor Delta esse Delta ele não é mais só aquele aquele valorzinho' de erro que a gente calculou lá na

no percebe Tron simples mas ele é o valor desse erro multiplicado pela derivada esse aqui a derivada derivada além da função de ativação Fi por isso que eu falei antes para vocês que a a função de ativação utilizado em qualquer neurônios dessa multilayer perceptron ela tem que ser derivada porque precisa ser derivada bom isso aí eu vou deixar até alguns vídeos para vocês verem depois mas é a derivada vai dar um uma direção digamos assim para onde que aquela atualização de pesos tem que se ela tem que ir para o lado positivo para um lado

negativo se ela tem que subir ou descer né então a derivada vai vai servir para isso aí você calcula esse valor Delta com base nesse valor Delta você atualiza cada um dos pesos desses desses neurônios aqui da camada oculta vejam que aqui ó fórmula para atualização dos pesos desses neurônios da camada oculta da camada de saída perdão é a mesma que vou e no percebe Tron elementar que usa que o valor Delta para multiplicar soma no valor de peso atual a taxa de aprendizado vezes o valor Delta que você cálculo aqui vezes a única diferença

tá aqui ó em vez de você multiplicar pelo X Você Vai Multiplicar pelo Wii o que que é se é a saída né do neurônio que tá passando por aquela entrada está chegando aqui nesse neurônio da camada de sair aí você faz isso e você vai ter os novos valores de peso aqui para cada um dos Tem que repetir isso aqui para cada um dos neurônios aqui né da camada de saída e aí você vai ter os novos valores de peso para ele feito isso você volta para o algoritmo e é que segue a partir

do Passo sim e você vai ter que fazer um cálculo do Delta né tá naquele fator de ajuste dos Pesos para cada um dos neurônios tá começando pela última camada oculta é só a gente tiver várias começa pela última né aqui no caso tem uma só só tem essa camada oculta aqui certo e aí você ajusta os pesos de cada neurônio dessa camada oculta usando essa fórmula de atualização de pênis vamos dar uma olhada como é que destrinchar essa fórmula que cada um desses pesos aqui de cada neurônio da camada oculta vai ser atualizado pelo

deve primeiro a gente tem que calcular o delta para depois atualizar o peso como é que calcule o delta Lembrando que o delta é que aí fator de ajuste é para onde que tem que ir a correção do peso a diferença aqui agora é que não é mais simplesmente o valorzinho' do erro simples Até porque o valor desejado né tá faltando aqui o erro é igual o valor desejado - a saída obtida neurônios da camada oculta na laçar o nosso Data Set não vai ter valor desejado e não sabe qual tem que ser aquela saída

daquele meu anjo sabe eu sair da final da rede Então você tem que levar em consideração a contribuição desse neurônio que e já que a saída dele se propaga para todos os neurônios na próxima camada você tem que levar em consideração a contribuição desse neurônio aqui no erro Delta e foi computado para cada um cada uma dessas camadas aqui vai dos neurônios da camada seguinte no caso é que tem um Delta a contribuição dele para casa neurônio da próxima camada que no caso tá sendo a camada n seria a próxima camada no caso de saída

Então você vai ter que fazer aqui um uma multi somatório de multiplicação de pesos versus deltas versus deltas da próxima camada para saber qual que é a contribuição desse neurônio aqui não erro obtido aqui para cada valor Y é uma vez que você calculou isso você tira de novo a derivada da função de ativação multiplica por essa derivada E aí você vai ter o valor Delta que é o fator de ajuste para aplicar aqui na fórmula de atualização de peso vejo que a forma de atualização e peso é a mesma pega o peso atual multiplica

pela taxa prezado vezes o delta vezes o valor de entrado daquele neurônio que no caso aqui tá sendo X e Y né sendo alguma dessas entradas aqui porque a gente não tem nenhuma outra camada oculta ainda se tivesse alguma outra camada oculta antes gente teria que usar daí a saída intermediária daquele neurônio da camada oculta anterior e refazendo esses Passos repetir esses Passos aqui até chegar na primeira camada oculta da nossa rede que essa primeira camada aqui que vai atualizar os primeiros p o digamos assim da nossa rede fazer a reta propagação da atualização com

isso você concluí um atualização de peso para uma entrada aqui no Passo 8 você vai repetir esses Passos aqui para cada uma daquelas outras entradas do seu Data Set que você tá usando para o treinamento feito isso apenas aqui no Passo 8 né que não passa oito depois de passar após todas as entradas fecha uma época o seu treinamento igual o percebe Tron elementar E aí você ao chegar aqui no Passo 8 você vai ter que ver se já posso parar o treinamento ou não né se chegou já no limite de épocas que eu estabeleci

pode deixar treinando por mil é mas por exemplo ou se atingiu um determinado critério de erro aqui agora não se aplica mais aquela estratégia simples que a gente viu e com ela não haver é nenhuma entrada apresentando o erro aqui agora a gente tem que olhar para um erro por exemplo um erro quadrático médio que eu deixei um link de um vídeo aqui explicando para vocês é porque disso né como é que isso aqui funciona porque agora a gente tem que tirar uma média dos valores de erro para cada uma das entradas e e como

aqui no caso a gente pode ter varias várias sair da Y saque é a gente tem que tirar uma média que leva em consideração a diferença entre cada uma dessas classes esperadas aqui eu deixei alguns links para você tirar a curiosidade CV imagem detalhes explicação mais detalhada né de como e até demonstração de como funciona esse treinamento aprendizado back-propagation essas demonstrações uma sugestão que eu dou é você fazer se quiser né praticar e fazer um um exercício eu não vou pedir para um exercício de treinamento né a gente vai fazer só um exercício de propagação

fica só como sugestão para você avaliar

Related Videos

15:07

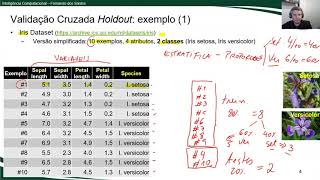

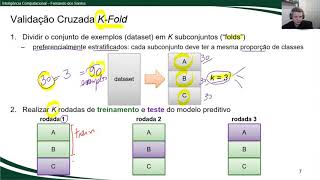

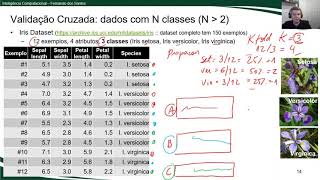

Avaliação de Modelos Preditivos: Validação...

Fernando dos Santos

1,316 views

9:33

Avaliação de Modelos Preditivos: Validação...

Fernando dos Santos

2,956 views

25:14

(ML) Redes neuronales ‐ Introducción

El Umbral

56 views

52:35

Unid1 QInstrumental T1T2 Prof Vagner Tebaldi

Vagner Queiroz

9 views

27:27

GEPECIM Resolve - ENEM 2024 - FÍSICA

Ciências e Matemática - GEPECIM

88 views

10:19

Avaliação de Modelos Preditivos: Matriz de...

Fernando dos Santos

842 views

14:44

Redes móveis - o que é uma célula? O que s...

Learning Wireless BR

3 views

7:20

Redes Neurais: Introdução ao MultiLayer Pe...

Fernando dos Santos

934 views

27:52

Campo Elétrico Parte 1

ARMANDO DE OLIVEIRA BRIZOLA

20 views

24:46

Formulação do Problema dos Jarros para Apl...

Fernando dos Santos

399 views

12:55

Java: diferença entre println e printf (co...

Fernando dos Santos

3,764 views

2:18:45

AULA 1 ELETRICIDADE BÁSICA BTMT ALAGOAS TE...

Manoel Barbosa (Neto)

12 views

23:38

Buscas em Espaço de Estados: Resolução do ...

Fernando dos Santos

1,019 views

6:45

Avaliação de Modelos Preditivos: Validação...

Fernando dos Santos

937 views

1:22:39

Preparatório Olimpíada de Física 2024 - Fí...

Olimpíadas de Física RJ

40 views

17:39

Programação Concorrente: Simulador de Tráfego

Fernando dos Santos

550 views

1:09:41

REVISÃO DE FÍSICA - PRÉ ENEM

DRE Rondonópolis Pré-Enem

56 views

1:27:30

#FabricCoffee | Rui Carvalho | Transformin...

Microsoft Fabric Café

478 views

34:46

#PYTHON MACHINE LEARNING (05): Avaliar des...

Python DS

2,101 views