QUAL O FUTURO PRÓXIMO DAS IAs? (vamos compreender as REDES NEURAIS antes...)

21.73k views7486 WordsCopy TextShare

Asimov Academy

Conheça a Trilha Aplicações IA: https://asimov.academy/trilha-aplicacoes-ia-com-python/?utm_campaign...

Video Transcript:

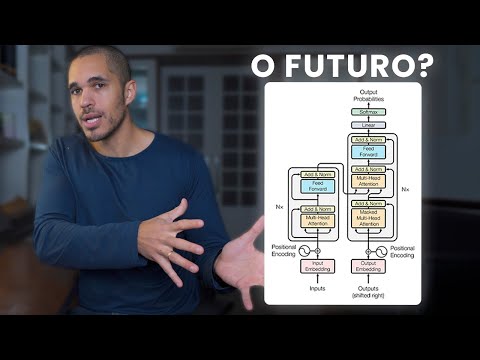

esse aqui é um meme clássico aonde todos os anos o pessoal atualiza Quantas vezes o termo ai foi citado na conferência anual do Google ai ai uses ai ai a a ai Só que essa obsessão por inteligência artificial na verdade não pertence só ao Google há mais de 2 anos que o mundo inteiro só fala sobre isso todos os dias saem notícias de que um novo modelo superou algum anterior de que novas tecnologias são lançadas que hoje conseguem fazer coisas que nós achávamos ontem que era impossível existe até um certo vício de algumas empresas quererem colocar o termo EA em coisas que não tem nada a ver com inteligência artificial só que quando se tenta projetar o futuro levando em consideração a existência das inteligências artificiais é que o assunto Fica ainda mais complexo porque parece que cada pessoa aqui na internet emite uma opinião completamente diferente uma da outra tem gente que acha que as eá vão acabar com todas as profissões Isso vai acontecer amanhã tem gente que acha que Inteligência Artificial Na verdade é um grande Hype e que o interesse pelo público vai acabar assim como as nfts acabaram a cerca de 4 5 anos atrás que esse Boom recente das ações da NVidia é só uma bolha tem gente que acha que essa é a nova realidade Então nesse vídeo eu quero trazer um pouco da minha visão sobre isso e compartilhar o que eu acredito que vai acontecer num curto prazo envolvendo inteligências artificiais O que que a gente pode esperar do mercado que coisas eu tenho prestado atenção em relação a ai e que eu acho que vocês também deveriam prestar só que antes de dar a minha opinião eu queria situar vocês em relação a alguns grupos de opiniões que se formam por aí em relação ao futuro da inteligência artificial em primeiro lugar eu tenho tenho visto opiniões emitidas por um grupo de pessoas que costumam ser mais leigas em relação ao funcionamento das inteligências artificiais e em geral eles costumam ser mais impressionados em relação aos lançamentos que saem por aí quem emite essas opiniões não costuma saber tão bem como as inteligências artificiais funcionam por debaixo dos panos então acabam não sabendo bem das suas limitações e o quão difícil é superar algumas das limitações que nós estamos vendo hoje em dia e por fim se tornam mais alarmistas de um outro lado eu tenho visto um grupo de profissionais que seriam mais expertos são são pesquisadores cientistas da Computação que não ficam tão impressionados com os modelos que a gente vê por aí em geral sabem como os modelos são treinados acompanham os papers que são lançados todos os dias esse grupo sabe bem das limitações dos modelos sabem diferenciar O que são novos modelos e o que são apenas sistemas que usam esses outros modelos na Inteligência Artificial e consequentemente esse grupo acaba sendo muito mais cético em relação a todo esse Hype criado e a minha opinião que eu vou trazer para vocês ela tá no meio do caminho eu tendo a não ser tão impressionado com as novidades que saem por aí mas ao mesmo tempo não tão cético eu entendo das limitações do modelo e sei como eles são construídos e toda a transformação da economia não vai acontecer tão rápido quanto parece mas eu acredito que ao mesmo tempo a tecnologia das llms especificamente não pode ser desconsiderada ela tem uma peculiaridade que pode mudar a forma como a gente constrói tecnologia para sempre e é isso que eu quero explicar para vocês agora então se a minha opinião ela é um equilíbrio Entre esses dois grupos Nada melhor do que explicar ela entrando em um desses grupos por vezes a gente vai começar entendendo como as inteligências artificiais funcionam e como a gente chegou até aqui desde que os primeiros computadores foram criados nós já viemos tentando adicionar formas de tornar eles mais inteligentes e muitos modelos diferentes já foram propostos ao longo de mais de 100 anos que obtiveram bons resultados em múltiplos Campos só que existe uma arquitetura que hoje domina Praticamente tudo quando a gente fala de inteligência artificiais que são as redes neurais e como o nome sugere as redes neurais elas são baseadas no funcionamento dos nossos próprios neurônios eu posso cometer algumas imprecisões aqui então me desculpem neurocientistas cada neurônio nosso está conectado com outras centenas milhares de neurônios através dos dentritos que são essas terminações nervosas aqui e ela informa outros neurônios e se comunica com os próximos da rede através dessa cauda que a gente vê aqui aqui estão as conexões com os próximos neurônios Então tudo isso aqui forma uma grande rede que forma o nosso cérebro que forma todas as nossas terminações nervosas e por mais que esse funcionamento aqui não seja muito claro para nós ainda a ideia Central é que toda vez que eu por exemplo encosto no meu braço alguns neurônios aqui eles são disparados eles sentem esse estímulo eles recebem uma quantidade de energia de sinais de outros neurônios que seriam suficientes para que ele Decida que ele deve disparar informar pro próximo neurônio que ele foi ativo e uma vez que esse neurônio é ativo ele vai informar outros neurônios os neurônios quando eles receberem uma quantidade de ativações maior do que um valor específico eles vão disparar também e é por isso que quando eu encosto aqui aqui existe uma rede que vai se conectando todo o meu braço e chega até aqui porque todos os neurônios em sequência vão percebendo que foram ativados pelos neurônios anteriores até que isso aqui chegue no meu cérebro e o Cérebro perceba que isso aqui se trata de uma de um estímulo de Tato se eu de repente cheiro alguma coisa e percebo existem neurônios diferentes aqui que se conectam e são ativados por uma sequência de outros neurônios que indicam que aquilo é um é um olfato e que tem um cheiro específico E por que que eu tô explicando tudo isso porque o primeiro modelo matemático a tentar produzir os neurônios é chamado de perceptron e percebam que ele tem uma estrutura aqui que para quem não tem muita familiaridade com matemática e álgebra linear esses números podem assustar um pouco eu prometo que eu não vou entrar tanto em matemática assim só um pouquinho para que vocês entendam a lógica da coisa mas a forma dele é inspirada meio que grosseiramente em neurônios e como é que funciona um perceptron um perceptron é um modelo que eu não tenho certeza se essa informação da wiquipedia tá certa mas a gente tá falando de Com certeza de uns 80 anos de existência ela é uma equação matemática que ela vai devolver um valor Y em função de alguns valores x de entradas ponderados por parâmetros aqui no meio e modificados por uma função de ativação aqui dentro Eu sei que entender isso aqui parece um pouco confuso mas compreender o funcionamento de um perceptron as suas limitações e como que isso aqui evolui e é construído vai ser a base para compreender tudo que vem depois na Inteligência Artificial então vamos aqui pro tablet e eu vou mostrar para vocês um exemplo muito simples de um problema que pode ser resolvido por por um perceptron como que isso aqui que tá um pouco confuso se entender pode ser traduzido em um exemplo super prático da nossa vida então um problema de Inteligência Artificial muito simples que é bem didático para entender a ideia de um perceptron então Imaginem que um médico está tentando construir um modelo matemático para prever se determinado tumor ele é maligno ou benigno então eles vão lá fazem uma biópsia do tumor que uma pessoa tá desenvolvendo e obtém alguma coisa assim vamos supor e aqui médicos peço desculpa para você isso aqui é só um exemplo que a única variável que ele vai levar em consideração nesse problema é a largura desse tumor obtido de uma forma específica a gente vai ter aqui um valor x por exemplo Então qual que é a ideia através da largura desse tumor coletado eles querem tentar prever se ele é um tumor benigno ou um tumor maligno esse tipo de problema aqui ele tem uma variável de entrada que é o que nós chamamos de feature é o que nós temos para tentar prever alguma coisa e nós estamos tentando classificar Isso em duas classes ou é benigno ou é maligno então isso se trata de um classificador binário se eu voltar aqui pro desenho do perceptron eu consigo trazer isso aqui de uma forma ainda mais simplificada para dentro para resolver esse problema a gente quer encontrar uma função matemática que seja função de apenas X1 e ela vai devolver um entre dois valores ou é um ou é zero essa função ela vai tentar prever pra gente se ele é benigno ou se ele é maligno se os pesquisadores conseguirem coletar muitas dessas amostras então por exemplo coletei vários benignos benignos benignos aqui e eles forem percebendo que em geral quando os tumores tiverem um tamanho maior do que um certo valor eles costumam ser malignos existe uma proporção maior aqui de de benignos do que malignos a partir de um certo ponto eles podem tentar encontrar uma lógica para descrever essa reta aqui e o perceptron pode ser utilizado para isso o percep funcionaria da seguinte forma a bolinha que ela vai receber aqui o valor X1 que é o tumor que a gente está observando e aqui eu teria um W1 que seria o que nós chamamos de parâmetro do modelo é o que vai caracterizar um pouco essa nossa nossa função alguma coisa vai acontecer aqui no meio que vai modificar o valor de X1 em função de w para que ele devolva 1 ou zero é isso que nós queremos entro com x multiplico por algum parâmetro faço alguma coisa mais aqui dentro e o resultado é um ou é zero é isso isso é um perceptron mais básico possível então aqui ficam duas perguntas O que que a gente faz com w e o que que existe aqui dentro a primeira proposta mais básica tá descrita aqui nessa caixinha da Wikipedia eles dizem que FX vai ser igual a 1 se w x x + b for maior do que 0 ou zero do contrário Então reparem que aqui está o nosso x aqui está o nosso w Eles colocaram um termo B aqui que eu não descrevi para vocês mas é um termo que poderia entrar nesse modelo e quando essa multiplicação aqui for maior do que zero essa minha função vai dizer que é 1 Então como é que a gente faz isso eu venho aqui e coloco X1 x W1 + 1 B qualquer Então essa operação matemática aqui pode não parecer mas ela é muito semelhante ao que está entrando no meu neurônio seria o estímulo que ele tá recebendo seria a informação que ele tá recebendo antes de decidir se ele dispara se ele liga se ele emite o próximo sinal pros pros pros neurônios seguintes ou não e nós vamos aplicar esse valor aqui dentro de uma função que leva o termo de função de ativação é ela que vai decidir se deve ou não deve disparar o seu valor e no nosso caso aqui o que que seria esse disparar é ele dizer se é um ou é zero e essa função de ativação mais básica possível aqui ela é o sinal correspondente aqui dentro se esse corpo aqui dentro for maior do que zero ele vai dizer que ele é benigno ou que ele é maligno então aqui eu quero fazer só uma observação para vocês X1 é o que nós estamos observando na natureza W1 e o b aqui seriam os parâmetros do nosso modelo percebam que a partir do instante que eu começo a modificar o w aqui essa equação aqui muda e ela vai parar de disparar em certos locais para começar a disparar em outro então isso aqui caracteriza a inteligência do nosso modelo e o produto no final aqui a conclusão dele é simplesmente essa função de ativação em relação a isso isso aqui que eu expliquei agora Pode parecer um pouco confuso mas é a base da base da base da base de uma rede neural tá é a coisa mais básica possível vocês vão ver daqui a pouco que esses elementin aqui quando começam a se juntar permitam que a gente saia de um modelo super idiota como esse para coisas absolutamente complexas como é fazer uma máquina falar só que antes de avançar nos modelos eu quero explorar um pouco esse modelo aqui porque os nossos pesquisadores aqui os nossos médicos Qual que é o objetivo deles com esse trabalho algum valor de w aqui na qual ele consiga montar uma separação perfeita entre tumores malignos e tumores benignos Dependendo de qual valor de w a gente coloque se eu for aumentando ou reduzindo É como se eu tivesse movendo essa minha curva que está agora nesse ponto verde aqui paraa direita ou pra esquerda o nosso modelo como ele se trata de algo muito simples ele não tem muita maleabilidade pra gente conseguir construir coisas mais complexas ele só consegue deslocar uma reta dura tá no nosso eixo X aqui porque se trata de um problema com uma variável de entrada com classificação de duas variáveis só que quando a gente vem nesse modelo de perceptron aqui que também é super básico ainda mas reparem que ele tem aqui X1 X2 X3 tem mais variáveis e estão sendo multiplicado por mais pesos aqui para permitir algum valor quando a gente começa a adicionar iar mais variáveis aqui o nosso modelo ele começa a ganhar complexidade ele começa a permitir que antes eu tinha só a maleabilidade de modificar horizontalmente uma reta vertical eu posso começar a colocar coisas um pouquinho mais complexas como de repente se eu coloco um X2 a minha curva resultante agora ela pode se inclinar de um jeito ou de outro e isso fica visualmente mais fácil de ser compreendido nesse site aqui que é o tensor Flow playground é um um site feito pelo Google pra gente poder visualizar um pouco uma rede neural como que ela funciona e se vocês prestarem atenção aqui eu tenho um perceptron aqui eu tenho um X1 entrando e ele pode escolher diferentes pontos diferentes tipos de dados aqui dispostos em um eixo bidimensional e vocês vão ver que à medida que a gente aumenta a complexidade desse sistema o nosso modelo ele tem mais maleabilidade para conseguir separar esses pontos então quando eu coloco só um X1 vamos supor que eu pegue esse esse conjunto de dados aqui que tem H uma classe um que é uma classe que poderia ser o tumor maligno Benigno poderia ser qualquer tipo de classificação que vocês pensarem aí o nosso modelo se eu mando ele treinar e encontrar esse parâmetro w porque quando eu vou dar o Run aqui ele vai tentar modificar os WS que estão sendo modificados para gerar coisas diferentes reparem que ele só consegue aqui nem nem nem fica tão claro vamos pegar esse outro aqui ó ele só consegue encontrar retas verticais porque é isso que o nosso modelo faz ele não é complexo suficiente para produzir coisas diferentes quanto a isso a partir do instante que eu adiciono para ele também um X2 que seria adicionar esses essa segunda possibilidade aqui ele vai tentar modificar o W1 e o W2 de forma que faç separação pra gente e olha que interessante antes o modelo que ele era duro agora ele conseguiu dar essa inclinad Dinha porque o X2 que ajudou ele a dar essa inclinada E se eu coloco o cursor em cima eu até consigo ver qual que é contribuição do X1 e qual que é a contribuição do X2 e quando eu tiro o cursor ele devolve a contribuição dos dois somados isso é muito interessante porque agora a gente teria dois duas variáveis de entradas que conseguem fazer separação num eixo bidimensional mas o que acontece se eu tentar construir separar este gráfico aqui percebam que a gente não vai conseguir fazer nada porque nós só temos a possibilidade de pegar uma reta dura e inclinar ela esse nosso modelo não tem complexidade o suficiente para poder dobrar essa reta e fazer com que ela desenvolva um círculo em volta então para isso que eles deram outras opções dá umas modificadas aqui nos nossos valores por exemplo X1 x X2 Olha que a curva Já é bem doida se eu mando ele rodar ele não conseguiu ainda vamos tentar adicionar outras coisas aqui ó se eu aumento a complexidade das variáveis de entrada a gente tem uma curva agora que consegue ser formada e vocês podem brincar bastante com os tipos de dados diferentes e vê que essas curvas de separações elas mudam beleza e agora eu sei que parece bem distante que que tem a ver futuro de Inteligência Artificial a gente tá desenhando curvinhas aqui porque Vocês entenderam como uma rede neural funciona e tudo que vai ser construído a partir daqui vai fazer um pouco mais sentido porque ver resolver problemas com poucos parâmetros cinco parâmetros é algo que já era possível de ser construído Há sei lá 80 anos atrás é o tipo de equação que tu consegue resolver quase que na mão só que a magia de uma rede neural é que a medida que a gente adiciona mais features eu também poderia pegar esses neurônios aqui eu poderia pegar o valor de saída desse neurônio aqui e transformar ele no valor de entrada de um outro neurônio por uma coisa semelhante é esta cara aqui reparem que aqui a gente tinha um perceptron aqui no meio só que agora este perceptron aqui ele tá servindo de entrada para outros perceptrons e a partir do instante que eu coloco mais features e mais parâmetros eu consigo ter um modelo matemático que na verdade consegue construir a forma de qualquer coisa aqui é fácil da gente visualizar essa complexidade do modelo Porque Nós seres humanos estamos acostumados a ver as coisas em duas dimensões então um problema que tenha esta complexidade aqui eu consigo ver claramente que ah o modelo conseguiu fazer um desenho tá conseguindo criar uma curva diferente para separar aquilo só que os problemas que a gente quer resolver na vida real Como é que eu sei que um cachorro numa foto é um cachorro como é que eu faço para um modelo entender a tradução de línguas como é que eu faço para modelo conseguir falar Eles são problemas muito mais complexos e é como eu vou dizer bem como bem simplificado aqui é como se nós quiser podos ter um modelo grande o suficiente para que ele consiga montar formas geométricas em um espaço gigantesco não só de duas dimensões aqui como a gente tá vendo mas de bilhões de dimensões que consiga resolver qualquer coisa e é para isso que a gente começa a conectar as redes neurais porque quando a gente conecta quantidade de problemas e as complexidades dos problemas se tornam muito maiores Então se vocês conseguiram compreender essa ideia de quanto mais fates a gente colocar aqui mais redes sai conectando tudo isso é como se o nosso modelo ele se transformasse numa massinha de modelar bem flexível eu consigo desenhar qualquer coisa porque se eu coloco uma feature é como se ele fizesse só isso quando eu coloco duas features eu consigo inclinar se eu coloco milhares de features É como se eu pudesse transformar isso aqui de um jeito tão complexo que ele consegue fazer uma Sei lá cara consigo fazer uma escultura do mikelangelo por exemplo porque ele ficou muito maleável então a ideia Central é mais features mais maleabilidade no modelo então já se sabia H sei lá 60 70 anos atrás que redes neurais TM a capacidade de ser a a função matemática a resolvedora perfeita ela consegue se adaptar a qualquer coisa o problema é que para poder se adaptar Qualquer coisa a gente precisa de uma quantidade de redes de redes internas aqui de parâmetros gigantescas porque aqui eu devo ter sei lá 15 20 parâmetros só que uma rede neural da prática para resolver coisas reais o chat GPT na versão 3. 5 se estima que ele tenha 180 bilhões de parâmetros então encontrar qual que é o número certo de cada um dos parâmetros para resolver adequadamente um certo problema não é uma tarefa simples só foi possível acerca de 15 20 anos atrás e eles perceberam nas primeiras versões de redes neurais que eles tinham encontrado um modelo muito poderoso só que eles não tinham ferramentas para poder treinar esse modelo para poder encontrar Quais são os parâmetros certos para resolver qualquer tipo de problema até que há cerca de eu acho que 20 anos atrás 2005 se eu não me engano voltou-se a atenção às redes neurais porque se começar a se desenvolver novas formas de se encontrar esses parâmetros com algoritmos conhecidos como Back propagation e a aprimoração dos nossos computadores as capacidades de processamento e alguns anos depois até começaram a utilizar placas de vídeo As gpus nas técnicas de otimização desses parâmetros que se permitiu que antes a gente treinava modelos pequenos a gente CONSEG cons treinar grandes modelos cada vez maiores então isso aqui foi uma introdução básica muito muito muito básica sobre redes neurais Então qual que é o próximo passo próximo passo é os pesquisadores começaram a desenvolver novas formas de reorganizar essas redes neurais aqui para resolver problemas diferentes então eles começaram ao invés de simplesmente Colocar todas as redes aqui interconectadas cara vamos cortar algumas conexões de alguns pontos aqui vamos vamos fazer com que essa rede se conecte com esses pontos aqui vamos fazer com que esse ponto se conecte com essa o que sai daqui Volte para cá Vá para lá ao mudar essas conexões e a forma como os dados eles são organizados a gente está modificando a arquitetura da rede neural e se percebeu que arquiteturas diferentes são melhores para certos problemas a gente tem uma arquitetura muito muito muito famosa chamado convolutional neuronet que ela permite que a gente Organize uma rede neural de uma forma isso que vocês estão vendo aqui esse desenho doido aqui aqui no meio é uma rede neural tá Não parece mas é uma rede neural que ela é focada em conseguir fazer classificação de imagens eu mostro uma foto para ela ela diz o que que é aquilo que objeto é aqui é um carro é uma galinha é um telefone é um microfone e isso eles fazem conectando cada pedaço aqui da minha imagem com o ponto da rede e ela vai disparando informações paraa outra rede quando por exemplo ah encontrei características de um carro nesses neurônios aqui e aí chega no fim ele diz que aquilo é mais ou menos um carro ele vai lá na hora de classificar ao invés de ser um classificador binário maligno e Benigno a gente pode colocar aqui milhares de classes no fim e ele consegue autp putar isso pra gente então a gente já tem uma lição que redes neurais elas são resolvedores universais elas são massinhas de modelar que se adaptam qualquer problema isso é um ponto e o segundo ponto é que a arquitetura da rede Neal a forma como esses dados Estão dispostos permite que a gente consigam resolver melhor certos problemas do que outros com volution on neuronet por exemplo que tem essa arquitetura doida é ótimo PR classificação de imagens mas não é tão boa para conseguir traduzir textos ou sintetizar voz ou mesmo imagens cada tipo de problema vai ter uma arquitetura diferente Existem algumas arquiteturas que eram muito utilizadas há 5 anos atrás se eu não me engano que er as rnns lstms que eram ótimas para conseguir fazer tradução de um idioma para outro até que em 2017 a gente tem um lançamento desse paper aqui attention is all un eles propõem uma arquit ura diferente para um problema de nlp que é processamento de linguagem natural tentar fazer máquinas falarem como seres humanos e muito se tentava utilizar uma arquitetura baseada em redes neurais só que ela tinha um problema específico que ela não conseguia entender muito relações distantes pela forma como a rede era proposta e eles propuseram essa nova arquitetura chamado Transformer que é muito complexa tá tem alguns vídeos até do de blue and Brown que eu recomendo para vocês que ele explica como arquitetura funciona só que isso aqui foi um Marco porque todas as arquiteturas anteriores estavam esbarrando num certo limite de qualidade e quando eles propuseram esses eles perceberam que eles destravar um certo limite só que o Transformer ela é a arquitetura base para todos os modelos de linguagem que a gente vê hoje em dia chat GPT Cloud 3 Gemini meta os modelos abertos A única diferença entre eles é a quantidade de parâmetros que os modelos de empresas fechadas são muito maiores se estima que o chat GPT 4 tenha por volta de 2 trilhões de parâmetros enquanto que os modelos abertos que a gente roda Nossa Máquina aqui Tem 8 bilhões 10 bilhões é uma diferença gritante e impacta diretamente na qualidade do modelo e alguns detalhes sobre como eles foram treinados mas em Essência Tudo é Transformer só que como esses modelos são muito muito muito gigantes precisam de muitos parâmetros treinar eles não é uma tarefa fácil e como que a gente faz isso primeiro lugar a gente poderia começar com common craw que é um uma base de dados que que de maneira simplificada é um conjunto de dados que baixou a internet pra gente 250 bilhões de páginas salvas nos últimos 17 anos aberto citado em mais de 10. 000 artigos então o ponto de partida para treinar uma rede geral é a gente ter base de dados massivas e de de comunicação da forma como o ser humano fala então common craw aqui é um ótimo exemplo então a gente teria aqui terabytes e terabytes de dados não tem nem ideia de quanto eu sei que uns modelos abertos pequenos um lhama do foram treinados eu acho que em 10 tb de dados posso estar posso tá sendo impreciso aqui mas é muito dado então o que que a gente faz a gente tem o conjunto de dados a gente monta um Transformer com parâmetros aleatórios e a gente quer que esses Transformers mudem os seus parâmetros existe uma técnica para fazer isso para ela se parecer cada vez mais com esse conjunto aqui só que é muito dado com muito parâmetro então isso aqui tem que ser treinado em um cluster de gpus uma técnica comum é tu alugar um cluster de aí milhares de placas de vídeos que placa de vídeo consegue treinar modelo de linguagem muito muito muito melhor é por isso que a Nvidia se tornou a empresa número um do mercado agora tu vai investir aí um 2 milhões de dólares alugando esse serviço e botar esse modelo para ser treinado por cerca de 10 15 dias para te ter acesso a um modelo pequeno e simples o lama 3 da Meta Que Tem 8 bilhões de parâmetros ele custou mais de 2 milhões de dólares para ser treinado e não eu não consigo nem imaginar Quanto custa um chat GPT da vida que é 10 20 vezes maior do que um modelo como esse Mas essa é a ideia então compreendido isso ficam aqui duas observações em primeiro lugar por mais que os chat gpts e outras llms produzam resultados Incríveis percebam o quão ineficiente ela é o quão lento é esse processo porque para poder aprender a conversar como Nós seres humanos eles precisaram ler a internet inteira por muito tempo a quantidade de texto que Elas tiveram que ler para poder aprender a comunicar é mais do que nós seres humanos leriam em 1000 anos sem sombra de dúvidas e Nós seres humanos possuímos aqui dentro alguma arquitetura que nós não fazemos ideia de como é que é muito muito muito muito mais eficiente do que o Transformer Transformer aqui é uma que Conseguiu resolver o problema mas ela é infinitamente menor e mais ineficiente do que a que nós temos aqui dentro a gente consegue resultados incríveis com modelos de linguagem já só que suando sangue e a segunda característica que eu acho que poucas pessoas estão percebendo é que a arquitetura é muito muito muito importante para que a gente tenha bons resultados em Inteligência Artificial e se ficou muitos anos 5 10 anos dedicando tempo tentando aprimorar rnms e lstms para que se pudesse descobrir uma arquitetura nova do transforma que tivesse melhores resultados eu acredito que no futuro daqui a 10 20 30 anos nós vamos encontrar arquiteturas que são melhores que o Transformes e que consigam resultados mais expressivos ainda do que os modelos de linguagem talvez se aproximem mais da eficiência que o nosso cérebro tem e não precisam des tanta energia quanto esses modelos TM só que galera nós estamos em 2024 a gente usa aí chat chpt gemina chat chpt agora versão 4 o daqui a pouco vai ter a 5 o cloud 3 lançou a 3.

5 recentemente e todos esses modelos usam uma arquitetura de 2017 ou seja daqui a pouco vão fazer 10 anos que essa arquitetura tá aí então percebam que as coisas não avançam tão rápido quanto essas empresas querem que a gente acredite que Avança as transformações e os novos modelos eles não acontecem de uma hora para outra eu acho que que talvez o próximo Transformer ou a próxima arquitetura talvez aconteça daqui a 5 10 anos e a próxima talvez de novo aquii a 5 10 anos então não vai ser amanhã que essas transformações todas vão acontecer Então esse é o primeiro ponto do que Porque alguns especialistas em cência da Computação não são tão comprados assim na ideia de a Porque eles sabem que as coisas não são tão rápidas que acontecem um pouco mais devagar e o segundo ponto é que esse modelo aqui é difícil explicar nesse vídeo tão curto que eu tô fazendo mas ele tem uma camada aqui Na verdade ele como um todo é assim mas essa camada aqui no fundo ela é ótima para trabalhar com isso que é o soft Max que isto aqui é um modelo probabilístico O que que significa isso que nem sempre as mesmas entradas vão dar origem à mesmas saídas existe uma probabilidade No final a gente tem aqui as palavras que o chat GPT ele gera elas são tiradas de uma distribuição aleatória esse vídeo aqui do TRE Blue One Brown acho excelente para mostrar isso só que a lógica de um Transformer é como se fosse um grande preditor de texto que a gente tem aqui no celular só que invés de jogar prever a próxima palavra a gente prevé joga uma frase para ele ele vai calcular devolver uma distribuição de probabilidades a gente escolhe uma dessas probabilidades em função da probabilidade da palavra joga aqui pega essa sentença joga de novo e assim parece que ele tá sintetizando o texto é assim que esse modelo funciona e o segundo ponto é como esses modelos são probabilísticos de natureza aleatória eles erram e eles erram muito isso é o que nós chamamos de Alucinação que é onde a gente conversa com o modelo de linguagem e ele devolve uma resposta que parece muito bem escrita parece certa mas é 100% mentira e é muito difícil a gente conseguir passar por cima de Alucinação ainda isso fazem com que os modelos de linguagem eles se tornem incertos e seja mais um impecílio para que essa toda essa transformação que algumas pessoas acreditam que as ias teriam aconteça de maneira mais rápida Então por um lado a gente tem especialistas que tão observando que as arquiteturas não avançam avançam tão rapidamente quanto o mercado acha que elas avançam que os problemas de Alucinação dos modelos são sérios e não permitiriam que eles pudessem sair substituindo todas as profissões porque não é algo simples de corrigir é inerente à natureza estocástica dos modelos e que a cada nova versão de modelo que é lançada chat GPT 4 4 o Gemini 1. 5 Cloud 3. 5 sonet as melhoras em relação às gerações anteriores estão sendo cada vez menores Então a gente tem visto cada vez ganhos menores o que tá indicando que nós estamos chegando num limite que essa arquitetura pode nos levar então todos esses argumentos que eu trouxe aqui agora podem servir de base para sustentar a tese de que ai é legal mas não é tudo isso só que de um ponto de vista mais leigo a gente não pode desconsiderar o fato de que nós estamos diante de uma tecnologia de fato transformadora só que a gente tem que entender como que vão ser essas transformações porque muitos lei que eu tenho visto acreditam que asais vão substituir tudo é como que elas trabalhariam na frente do ser humano elas vão substituir designers vão substituir programadores médicos arquitetos e o ser humano não seria mais necessário porque ela consegue dar algumas respostas convincentes mas o que a gente percebe quem já tá trabalhando com ai há um certo tempo que as alucinações não permitam que isso aconteça e que elas Na verdade são incríveis para trabalharem conosco dentro do nossos sistemas e nos ajudando e não nos substitu indo pelo menos não nesse momento e talvez não com as arquiteturas de Transformers que eu apresentei até agora Então como que seria essa forma Imaginem se a gente tivesse falando de sei lá um cozinheiro por exemplo o leigo tende achar que as Iá vão poder substituir fazer todo prato de comida pra gente quando na verdade elas podem e devem revolucionar a nossa sociedade trabalhando como bons assistentes propulsion Nossa produtividade e não nos substituindo deixa eu mostrar alguns exemplos de como todo mundo já tá acostumado aqui a ter conversas com o chat GPT tirar dúvidas com esses modelos e aprender coisas eu mesmo tô pegando algumas dicas aqui para como montar um novo servidor só que existe uma forma de trabalhar com Ai que é muito muito muito interessante chamado construção de Agentes um agente nada mais seria do que um sistema que a gente desenvolve só que este sistema ele está utilizando uma llm como núcleo de tomada de decisão eu vou voltar aqui no tablet fazer um desenho para explicar como que isso muda a forma como o software é construído tecnologia no geral é construída a imensa maioria das tecnologias que vocês já utilizaram hoje em dia seja no celular no computador Netflix qualquer rede social sistemas que vocês usem aqui o próprio vs code eles são construídos na lógica de algoritmo o que que é a lógica de algoritmo o programador ele precisa especificar passo a passo que a máquina deve seguir para poder atingir um certo objetivo tá esse passo a passo ele tem que ser bem explícito então por exemplo quando eu clico aqui em cima existe um código escrito na linguagem que foi utilizada para construir aqui o vs code que diz cara quando tu clicar aqui em cima vá em tal lugar abra e mostre essa essa janela aqui com essa dimensão com esse texto tudo isso é explícito passo a passo isso tem um ponto positivo e um ponto negativo que os sistemas eles acabam sendo limitados pelos caminhos que o programador consegue descrever em Passos sequenciais então coisas que eu sei como explicar para um computador seguir de maneira literal eu consigo traduzir um software eu consigo ensinar um computador a fazer operações matemáticas eu consigo ensinar ele a mostrar algumas ferramentas eu consigo ensinar ele a construir um photoshop para mim só que um algoritmo ele tem essa limitação o que eu consigo descrever em Passos limita o que o computador vai ser capaz de fazer então se eu só souber explicar para ele essa área em verde ele só vai conseguir atingir aquilo o ponto positivo é que a gente tem consistência e O negativo é que a gente tem limitação eu até decidi p pegar aqui um um livro que eu tenho que exemplifica essa lógica de algoritmo que é um livro focado em aprendizado de máquina Inteligência Artificial e ele mostra aqui um pouco dessa lógica de algoritmo que eu acabei de explicar para vocês então como é que eu resolvo um problema específico eu escrevo as regras ponho para rodar eu avalio se essas regras estão atingindo o resultado que eu gostaria analiso os erros e reestudo o problema quando a solução ela é boa eu lanço ele tá essa é a lógica de algoritmo que eu Acabei de explicar mas o que que acontece quando a gente tá diante de problemas que eu não sei descrever passo a passo por exemplo como é que eu faço para um computador enxergar e explicar o que ele tá enxergando porque ele enxerga os as imagens e vídeos para Ele são matrizes com números zero 1 com as colocações RGB mas como é que eu sei e digo para ele que aquela sequência específica representa um cachorro ou um gato ou como é que eu sei que ele deve fazer uma tradução de uma língua para outra como é que eu sei que ele deve conversar comigo como é que eu sei que ele deve analisar minha voz em entender que aqui eu tô falando com clareza Mas de repente eu posso mudar o tom e falar com medo ou falar com amor com intensidade como é que entende quais são os passos em relação a isso Nós seres humanos da forma como a gente pensa a gente não consegue colocar todas as coisas em regras é como como se diz nós somos seres muito mais inteligentes do que nós mesmos conseguimos compreender E aí para isso desenvolve uma nova forma de atacar problemas que é a gente vai lá e estuda o problema inventa um algoritmo de aprend usado de máquina aonde esta caixa aqui com um conjunto gigantesco de dados que a gente não sabe muito bem como mas aqui estão as redes neurais e os dados que eu mostrei para vocês eles vão ser treinados para poder encontrar uma solução sem que eu saiba Como que essa solução foi feita dentro dos panos a gente não sabe como que o chat GPT fez o que fez ele tem 180 bilhões de parâmetros a versão pequena dele é impossível qualquer ser humano olhar lá entender ah a regra foi essa porque é muita coisa paraa nossa mente conseguir compreender mas O interessante é que a gente consegue ver o problema e a solução essa caixa aqui no meio e a gente consegue ter a resposta triste ou verdadeira se ou ou ou feliz se isso deu certo Ou se deu errado e a gente pode lançar o problema ou analisar os erros a partir daí então tudo isso para explicar para vocês que modelos de linguagem e é o que eu acredito a gente vai começar a utilizar cada vez mais eles dentro dos nossos próprios sistemas de sistemas que antes eram feitos basicamente por algoritmos cada vez mais vão ter modelos de linguagem nos ajudando a tomar melhores decisões a guiando e tornando a solução proposta cada vez mais complexa eu vou dar um exemplo muito pequeno aqui de um sisteminha que eu tô recé começando a desenvolver tá que é um assistente que eu quero fazer aqui para de comunicação aqui a gente teria praticamente um um chat GPT não tem nada muito muito além disso tá eu poderia colocar texto e a gente já conhece mas esse modelo aqui eu dei a capacidade para ele utilizar algumas ferramentas do meu computador no caso ele consegue tirar um print screen e descrever a minha tela então por exemplo poderia passar para ele aqui um comando de voz olá você consegue me ajudar no vs code na minha tela agora eu quero que você descreva para mim as linhas que estão selecionadas ele vai fazer uma transcrição da minha voz vai colocar aqui tá reparem que aqui tá minha transcrição ele já chamou a função de ScreenShot tá utilizando um outro modelo para descrever o que tá na imagem guiou aquele outro modelo sobre o que que ele precisa ver na resposta e aqui está a resposta dele ó olá sim eu posso ajudá-lo no vs code para isso preciso saber quais linhas estão selecionadas na sua tela por favor selecione as linhas que você gostaria que eu descreva e eu farei isso com prazer Claro que ele não tá muito perfeito ainda eu recém comecei a fazer ele mas qual que é a ideia é um modelo de linguagem capaz de controlar funções do meu computador isso aqui seria equivalente a eu programando por algoritmo no passado combinado com uma llm que decide o que fazer e que outros tipos de sistemas podem ser construídos com com isso nós nas Imóveis estamos desenvolvendo um projeto que usa llms para poder analisar vídeos de o Instagram categorizar esses vídeos e nos propor a partir de tendências que estão saindo no mercado conteúdos que a gente pode fazer baseado na nossa própria forma de comunicação ele Analisa essas formas e fica fazendo um scraping analisando esses vídeos e criando um grande banco de dados de vídeos com essas categorizações todas isso seria impossível através de modelos antigos de algoritmo mas que com llm combinado com uma estrutura de algoritmo a gente consegue ter esse tipo de resultado Existem muitos frameworks diferentes que permitem que llms usem software aqui eu tenho por exemplo um react Framework é uma forma da gente conversar com modelos de linguagem que permite que elas chamem funções e a partir daí comecem a construir coisas diferentes então resumindo tudo isso mesmo para quem não é programador Qual é a minha leitura do futuro eu acho que o assunto do momento agora é construção de Agents é como integrar esses modelos que já são incríveis o suficiente não para que eles Façam tudo mas para eles que se tornem especialistas em pequenas coisas e executem aquelas pequenas coisas a um nível sobrehumano isso dificilmente aconteceria num chat GPT 5 num chat GPT 6 porque eles vão seguir sendo tentando ser genéricos mas quando a gente pega esse modelo coloca dentro de um problema específico mune ele de ferramentas e de dados e de feedbacks para ele entender quando ele tá errando e Minimizar as alucinações é que a gente a gente vai conseguir construir um um novo tipo de software não sei qual software 3.

Related Videos

44:02

O mínimo que você precisa saber sobre IA p...

Diolinux

30,748 views

17:59

Esse é o "Novo Mercado de Tecnologia"?

Código Fonte TV

152,020 views

58:38

AI and The Next Computing Platforms With J...

NVIDIA

3,538,976 views

24:53

Seu PC do futuro vai ter um CHIP desses aq...

Diolinux

80,714 views

13:28

5 DICAS de IA que EU USO no meu dia a dia

Manual do Mundo

299,890 views

1:30:08

Entendendo Como ChatGPT Funciona - Rodando...

Fabio Akita

399,576 views

18:53

O livro que MUDOU a forma como eu ESTUDO e...

Asimov Academy

253,108 views

24:47

Inteligência Artificial vai destruir o fut...

Atila Iamarino

200,396 views

17:32

Como funciona mercado da IA? A próxima BOL...

Asimov Academy

78,980 views

45:22

CEO of Microsoft AI speaks about the futur...

NBC News

274,532 views

31:24

O ÚNICO sistema de ORGANIZAÇÃO que funcion...

Asimov Academy

317,256 views

10:01

AI, Machine Learning, Deep Learning and Ge...

IBM Technology

75,648 views

19:33

Coloquei o CHATGPT para jogar XADREZ contr...

Asimov Academy

293,521 views

27:42

Como usar o GPT com seus próprios dados?

Asimov Academy

69,423 views

1:27:47

Discovery Brasil | Inteligência Artificial...

Discovery Brasil

4,376,300 views

8:51

As 3 etapas da inteligência artificial e p...

BBC News Brasil

459,696 views

1:47:16

AS SOLUÇÕES (E OS PROBLEMAS?) DA INTELIGÊN...

Flow News

120,609 views

17:13

Rode IAs na sua PRÓPRIA MÁQUINA

Asimov Academy

26,297 views

29:19

Nova Análise de Dados do ChatGPT-4o é SURR...

Negócios em Mente

138,116 views

15:28

Por que você não deveria CONFIAR em IAs

Ciência Todo Dia

451,000 views