Aprendizado Profundo - Introdução ao Aprendizado Profundo

2.25k views3637 WordsCopy TextShare

UNIVESP

Nesta videoaula, o Prof. Marcos Quiles irá revisitar alguns conceitos fundamentais sobre inteligênci...

Video Transcript:

[Música] Olá a todos e todas Meu nome é Marcos killes eu acompanharei vocês ao longo dessa disciplina desse curso de aprendizado profundo então nessa primeira vídeo aula nós vamos fazer uma pequena introdução ao aprendizado profundo para isso nós vamos começar revisitando o que que a inteligência artificial conhecer a evolução da área como que foi Como que aconteceu o surgimento da área de aprendizado profundo o que que é o aprendizado profundo e algumas aplicações do aprendizado profundo tanto no nosso cotidiano como em tarefas que não são tão do nosso cotidiano assim bom que que a inteligência

artificial nós temos diversos definições na literatura mas nós podemos sumarizar basicamente todas as definições da seguinte forma são modelos computacionais que tentam de alguma forma imitar o comportamento ou as funções dos seres humanos para resolver tarefas complexas por exemplo reconhecimento de imagens cálculos específicos E para isso o sistema de ar ele tem que realizar diversas subtarefas por exemplo o sistema de ar ele tem que perceber o meio no qual está inserido então se eu tenho um robô atuando no meio ele precisa perceber ele precisa capturar a informação desse meio ele precisa raciocinar a partir do

conhecimento prévio adquirido a partir do conhecimento prévio fornecido pelo seu programador por quem conceber o programa ele precisa atuar nesse meio se a gente pensar em dar um exemplo do robô eu tô agindo no meio então se eu tô buscando um dado objeto ao encontrar esse objeto eu preciso pegar esse objeto e também a capacidade de aprender se eu tô recebendo informações do meio e essas informações me fazem atuar de alguma forma essa forma pode ser boa ou ruim por exemplo eu posso utilizar essa informação para tentar readaptar os meus parâmetros ou seja aprender a

partir dos meus acertos e erros de tal forma melhorar minha capacidade ao longo do tempo então os temas de ar eles têm de alguma forma eles têm que incorporar todo esse processo sendo que a tarefa de aprender especificamente ela está relacionado a área de aprendizado de máquina que é uma sub área da inteligência artificial nosso dia a dia nós temos diversas aplicações que utilizam ou na sua totalidade para solução total do problema ou como a solução parcial do problema sistemas que de alguma forma envolvem mecanismos de Inteligência Artificial como por exemplo softwares para detecção de

spam em ferramentas de e-mail tanto Gmail como diversas outras ferramentas é ele classifica de maneira automática um dado Spa um dado e-mail como sendo ou não spam Como que ele faz isso ele tem algum sistema ali um classificador que é responsável por coletar informações do e-mail e Com base no conhecimento prévio adquirido definir se aquilo é um possível spam ou não é um possível spam sistemas de recomendação toda vez que nós entramos num sistema de compras numa livraria ou qualquer obra de eletrônicos é os sistemas eles fornece pra gente ó com base naquilo que você

tá colocando no seu carrinho Provavelmente você vai gostar desse item aqui também tem um sistema de ar por trás fazendo essa recomendação de acordo com os hábitos de acordo com a rotina do usuário classificação de fotos dado uma foto que que tem nessa foto É uma imagem de um cachorro é um gato um carro então nós temos temas de a que podem ser utilizados para fazer isso reconhecimento de imagens bastante comum hoje nós temos no tanto no Google fotos como no Facebook diversas ferramentas de baseadas em redes sociais no qual nós temos a publicação de

fotos e o sistema reconhece de maneira automática é quais são as pessoas que estão naquelas fotos você já conseguem rotular essa pessoa a pessoa uma essa que a pessoa 2 Então tem um sistema de ar também por trás desse processo de reconhecimento desenvolvimento de carros autônomos Ou seja eu coloco um carro para atuar no dado do sistema ele tem diversos obstáculos tem as leis de trânsito então a gente pode utilizar sistemas de ar para conduzir esse carro de maneira autônoma dispositivos de casas inteligentes como Alexa da Amazon dentre outros que de alguma forma fazem reconhecimento

de áudio conseguem realizar tarefas específicas como você pede por áudio ela toca uma música A B ou C ela consegue capturar essa informação de áudio e executar aquela função também tem sistemas de a envolvidos os nossos dispositivos eletrônicos smartphones por exemplo também possuem diversas rotinas de inteligência artificial e por fim a geração de texto do tão falado chat GPT que a gente tem na mídia que está sendo está sendo uma espécie de disrupção no que a gente chama de Inteligência Artificial ou seja um ponto de transição onde nós tínhamos algo anterior e algo posterior ao

chat GPT diversos nomes da literatura o próprio Bill Gates é tem falado que a o surgimento de ferramentas como chat de PT representam pra gente o próximo passo da inteligência artificial mas não começou de hoje a inteligência artificial começou na década de 50 e ela ao longo dessas décadas ela teve uma evolução relativamente lenta com períodos de alta e período de baixa como a gente vai ver ao longo dos próximos slides só que recentemente nós temos a introdução de novos ingredientes em particular a produção e captura de dados de forma abundante ou seja se eu

quiser coletar informações de imagens hoje a gente consegue fazer isso na na web na internet com uma velocidade muito grande e conseguir um volume muito grande de imagens isso vale para qualquer tipo de dado se eu pensar em áudio se eu pensar em dados de e-mails diversas informações de compra e venda de produtos nesses mercados virtuais a gente consegue então o volume de dados muito grande que a nossa era denominada ela do Big Data E também o segundo ingrediente muito importante que é o advento das unidades de processamento gráfico as gpus então esses dois ingredientes

eles de certa forma eles acarretaram o surgimento denominada a área de aprendizado profundo Aqui nós temos um timeline de alguns pontos importantes da evolução da área tanto de ar como da área de aprendizado de máquina até a gente chegar na área de aprendizado profundo começando lá na década de 40 com o desenvolvimento do primeiro neurônio artificial neurônio MCP produzido pelos pesquisadores mcpitz aí na década de 50 o desenvolvimento da primeira rede neural perceptron que nada mais era do que um neurônio MCP agregado de um algoritmo de treinamento na década de 60 a proposição do adaline

a década de 70 que foi o nosso inverno na área de redes neurais artificiais onde o Miss que o Papa tinha demonstraram que a rede perceberam embora interessante ela não conseguir resolver problema simples problemas não lineares como choro então que desencadeou ao longo dessa década um dos interesses pela área de redes neurais aí na década de 80 nós tivemos um ressurgimento do interesse pela área principalmente com Advento do algoritmo de reto propagação propósito lá pelo romeliatti Williams e por outros com autores basicamente na mesma época aí na década de 90 nós tivemos a introdução das

máquinas de vetores de suporte pelo vapnik as sbms em 2006 nós tínhamos um artigo publicado na sais pelo próprio grupo do professor de offre hinton é no qual ele mostrou que uma forma bastante interessante de nós treinarmos uma rede com muitas camadas uma rede profunda para criar representações para dados de alta dimensionalidade ele mostrou um algoritmo basicamente com catenando uma máquina específica que a máquina restrita de boltsman uma forma da gente treinar ela camada camada depois com catenar essas camadas fazer empilhamento das camadas e fazer um ajuste dessas camadas com algoritmo de retropropagação é e

conseguir resultados surpreendentes Então nesse ponto nós temos o primeiro a primeira Faísca da área de aprendizado profundo ou seja o Jofre ele mostrou que sim a gente poderia treinar modelos profundos para fazer tarefas bastante interessante Então se a gente pensar na no desenvolvimento da área de aprendizado profundo especificamente a gente tem a pré-história né antes de 2000 a gente só tem termos depilary lá da década de 80 da década de 70 o próprio modelo neocognetron do fukushima proposto na década de 70 início da década de 80 já era uma rede um modelo relativamente profundo só

que nós não tínhamos aqueles dois ingredientes que eu comentei que era a quantidade de dados suficientes para treinar modelos com uma grande quantidade de parâmetros e o custo de Treinamento desses modelos eram bastante altos sem pensar só no uso da cpus é a gpus possibilitaram esse esse treinamento mais mais eficiente aí o primeiro modelo profundo com aplicação bastante prática foi de fato o modelo a lenet 5 proposta pelo lecon lá em 98 para classificar dígitos a gente vai ver ao longo da próxima semana do curso aí o artigo do jofrey Hilton em 2006 mostrando o

impacto das diversas camadas empilhadas para fazer o aprendizado de representações aí nós temos em 2009 um workshop do nips ele é a principal conferência que nós temos na área de redes neurais basicamente todas as grandes evoluções que nós temos dentro dessa área elas são é prioritariamente publicadas dentro dessa conferência em 2009 nós temos o primeiro workshop de aprendizado profundo para tratamento de sinais de áudio aí em 2012 nós temos a proposta da Alex net que a gente vai entrar também em detalhes na segunda semana do curso e esse ponto aqui como 2006 foi a primeira

Faísca que eu comentei para o surgimento da área de aprendizado profundo em 2012 Alex net ela foi de fato o modelo que acarretou no surgimento desse grande interesse pela área de aprendizado profundo a gente vai entender o porquê disso posteriormente mas antecipando basicamente ela conseguiu superar modelos tradicionais de visão computacional como uma margem de por cento o que era bastante não plausível para época os modelos tradicionais competiam lá para ganhar meio por cento de acurácia é ganhar 1% de acurácia e a Alex net ela conseguiu superar isso com uma margem de 10%. então mostrando que

de fato os modelos profundos eles conseguiam tratar dados reais especificamente imagens nesse caso aí 2014/2015 nós tínhamos as grandes empresas é começando a utilizar ferramentas baseadas e aprendizado profundo por exemplo a Google comprou a Deep mini que é uma Startup britânica que desenvolve modelos profundos o Facebook desenvolveu o Deep Face responsável é definir encontrar as pessoas e classificar essas pessoas de forma automática em fotos então publica uma foto no Facebook a gente vê que já aparece um tagzinho mostrando essa aqui é a pessoa a pessoa b a pessoa ser e assim por diante em 2016

um outro ponto importante foi que o alfagou ele conseguiu vencer o campeão mundial do jogo Gol Liceu numa disputa bastante intensa mas ele conseguiu a máquina conseguiu vencer o que já tinha acontecido com jogos de xadrez lá na década de 90 mas o gol é um jogo com uma quantidade de dimensões a quantidade de alternativas muito maior do que o jogo de xadrez então é um jogo bastante difícil de ser tratado então só lembrando meu aprendizado profundo nada mais é do que uma sub- área um subconjunto da área de aprendizado de máquina que por sua

vez é um subconjunto da área de inteligência artificial mas o que que é o aprendizado profundo a gente pode pensar que são modelos de aprendizado de máquina é que apresentam para a gente uma grande capacidade de aprendizado distrair padrões a partir de dados brutos então a gente fala que na abordagem and to Angel ou seja fim a fim e ao invés de pegar um dado específico uma imagem por exemplo extrair características dessas imagens e depois alimentar o modelo de aprendizado de máquina com essas características extraídas o modelo de aprendizado profundo ele vai pegar a partir

da imagem bruta e gerar a nossa saída por exemplo a classificação da imagem com mínima interação de um engenheiro de atributos tentando extrair de maneira manual atributo daquela imagem o próprio modelo vai tentar aprender isso de forma automática tá bom e com essas diversas camadas que a gente vai encontrar no modelo a gente consegue criar uma hierarquia de representações Ou seja a gente vai ter a primeira camada responsável por extrair características simples vamos pensar no contexto de imagens se não tiver imagem sua primeira camada ela vai extrair características bastante elementares como cores retas padrões muito

específicos uma segunda camada vai utilizar essas atributos extraídos na camada anterior para compor atributos de mais alto nível por exemplo posso pegar três retas e formar um triângulo uma próxima camada pode pegar essas formas geométricas criadas e criar objetos mais complexos camada camada até chegar no nível de mais alto nível semântico Por exemplo essa imagem contém um carro essa imagem contém uma pessoa e assim por diante Então como que os modelos de aprendizado profundo são criados Na verdade nada mais são do que modelo de redes neurais artificiais Associados a uma técnica de otimização responsável por

definir os parâmetros dessa rede profunda com diversos com diversos parâmetros Então a gente tem um método de otimização que vai ser utilizado propagação e variações que vai ser utilizado para treinar esse modelo uma grande quantidade de parâmetros utilizando um grande volume de dados aqui só para ilustrar para vocês a importância da representação dos dados Aqui nós temos exatamente os mesmos dados na esquerda e na direita só que aqui na esquerda nós temos os dados representados em coordenadas cartesianas então nós temos objetos da classe Verde aqui e objetos da classe azul ao centro do lado direito

nós temos os mesmos objetos os mesmos pontos só que representados por coordenadas polares que que a gente observa aqui se eu pensar nessa representação da direita uma simples reta passada entre essas duas classes é suficiente para separar o que tá na classe verde da classe azul ou seja é um problema linearmente separado já no objeto da esquerda na figura da esquerda a gente precisa de uma superfície não linear uma elipse uma circunferência para fazer essa separação do que tá dentro e o que está fora dessa elipse classe azul da classe Verde ou seja um problema

mais complicado um problema uma separação não linear então basicamente mudando a representação se a gente tiver uma representação adequada a gente consegue tratar um problema de maneira mais simples se eu tenho uma representação inadequada esse problema vai ter um tratamento mais difícil ou mesmo a gente não vai conseguir encontrar uma solução para aquele problema então só para deixar claro a importância da representação dos dados que é exatamente um dos grandes das grandes vantagens dos modelos profundos que eles vão ser capazes de tentar extrair de forma automática a representação necessária para conseguir fazer um mapeamento entrada

saída então aqui uma ilustração de diversos cenários possíveis aqui embaixo nós temos cenário mais simples onde nós teremos uma entrada fornecida um programa esse programa um programa tradicional com um conjunto de regras e a saída do modelo e essa é um cenário é simplificado aqui classificar-se uma pessoa está ou não com febre Então se ela tá com febre eu vou apresentar uma temperatura se essa temperatura maior que 37 está com febre se não não está com febre claro que esse é um problema bastante simples se eu tiver problemas mais complexo por exemplo imagens o que

que eu poderia fazer então ao invés de pegar simplesmente a imagem bruta eu poderia extrair características dessa imagem existem Contorno específicos existem cores específicas criar um vetor de características que é se características que eu devo extrair dessa imagem para compor esse vetor e esse vetor vai ser apresentado para um modelo de aprendizado de máquina agora não um programa tradicional um programa baseado em aprendizado de máquina que vai aprender a mapear características extraídas da nossa entrada até a respectiva saída num próximo nível ao invés de utilizar agora características definidas por um engenheiro de atributos a gente

vai colocar um próprio modelo de aprendizado de máquina para tentar extrair essas características de forma automática ou seja evita tentar evitar aquela possibilidade de escolher atributos errados características erradas que não permitam a realização de mapeamento entrada saída de forma correta ou de forma satisfatória então no primeiro nível Aqui nós temos a primeira aprendizado de características depois o próprio mapeamento do modelo das características na sua saída e no último nível nós teríamos um conjunto de situações de características que era exatamente que define o modelo profundo a gente vai ter uma quantidade uma organização hierárquica dessas características

extraindo a partir de características simples utilizando essas características para formar características mais complexas e assim sucessivamente camada camada até realizar um mapeamento na saída dos dados essas duas abordagens de cima aqui está associada aquilo que a gente chama de aprendizado de representações que algo bastante característica uma das grandes vantagens também do aprendizado profundo é o seguinte esse aqui é uma figura tradicional que a gente tem em diversas artigos diversas aulas relacionadas a aprendizados profundo que fala o seguinte aqui no eixo X nós temos a quantidade de dados e no eixo Y performance do modelo quando

a gente pensa em técnicas tradicionais uma svm por exemplo quando a gente aumenta a quantidade de dados a partir de um certo ponto não adianta mais aumentar essa quantidade de dados que a gente atinge um platô então o modelo não vai ampliar sua performance naquele cenário não importa quantos dados eu for nessa mais já com o aprendizado profundo dado a quantidade de parâmetros que a gente tem e a flexibilidade no modelo e a capacidade de ele aprender a extrair os dados brutos as próprias características que representam da melhor forma de sinal nós temos que aumentando

a quantidade de dados nós conseguimos sim melhorar a performance do modelo algumas ilustrações aqui minha ilustração do próprio chat GPT onde o usuário pergunta é como que eu faço para invadir a casa de alguém aí o chatie PT responde eu não é apropriado discutir ou encorajar atividades legais e segue comentando gerando um texto de forma automática com base naquela resposta fornecida fornecida pelo usuário esse modelo é um modelo profundo é treinado com uma grande quantidade de dados de tal forma que ele consegue uma vez treinado receber aquela informação aquele último caso a pergunta e tentar

deduzir gerar um texto a partir do conhecimento prévio adquirido aqui uma outra aplicação é uma ilustração de uma aplicação bastante comum também que seria o reconhecimento de objeto em cenas Então a gente tem uma imagem qualquer eu quero reconhecer os objetos e classificar esses objetos então aqui eu tenho um carro eu tenho uma bicicleta Eu tenho um cachorro e assim por diante uma tarefa bastante comum também dentro da área de aprendizado profundo geração de imagens Isso aqui é uma tarefa relativamente nova começou mais ou menos dez anos atrás essa geração de imagens artificiais a partir

do modelo generativos e Aqui nós temos duas figuras de duas pessoas que não necessariamente existem elas foram geradas a partir de um modelo é agenerativo é de aprendizado profundo Ou seja a gente treina essa essa rede esse modelo com uma grande quantidade de imagens e depois a partir de uma condição Inicial ela vai gerar uma dada imagem Então esse site aqui desse personal a cada interação que você faz com com o modelo aqui um outro cenário geração de moléculas equivalente o anterior só que agora em vez de gerar Faces né imagem de pessoas eu vou

gerar compostos químicos Então posso gerar moléculas a partir de um conhecimento prévio aprendido Pelo modelo de moléculas válidas então a gente pode utilizar isso para gerar por exemplo novos compostos novos fármacos novos materiais e também gera novos quadros novas novas obras de artes também de forma totalmente automática feita pelo computador então aqui o modelo é treinado com imagens de obras reais e a partir de um certo ponto ele aprende a Gerar dado uma condição Inicial gerar obras como essas que estão mostradas na tela e aqui tá o link que a gente pode definir essas imagens

e diversas Outras aplicações né como visão computacional predição de Mercado de Ações mercado financeiro em medicina reconhecimento de imagem se existe ou não um dado tumor numa imagem tomografia pode ser utilizado no modelo de aprendizado profundo em ciência de materiais Como mostrei a geração de moléculas geração de outros materiais é geração de textos e notícias Como o próprio chat GPT análise sentimentos em redes sociais dado um review fornecido por uma pessoa esse esse texto traz um sentimento positivo ou um sentimento negativo a pessoa assistir um filme Ela gostou ou não eu consigo fazer de forma

automática também utilizando modelos de aprendizado profundo além de diversas outras como jogos robóticas dentre outros bom que que nós vimos nessa aula então nós revisitamos o que que é inteligência artificial encaixamos dentro daí a área de aprendizado profundo recordamos algumas aplicações cotidianas da Inteligência Artificial compreendemos o que que é aprendizado profundo e como que eles surgiu como que foi feito Como que aconteceu a evolução dessa área e por fim conhecemos algumas aplicações na próxima vídeo aula nós vamos conhecer as redes neurais Profundas que são representa base para a gente dos modelos profundos entender o que

que a profundidade de uma rede neural e compreender o mecanismo de transferência de aprendizagem ou aprendizado por transferência chamado transferir bom é isso agradeço a atenção de todos e até a próxima vídeo aula [Música] [Música]

Related Videos

20:16

Aprendizado Profundo - Redes neurais e o a...

UNIVESP

967 views

1:38:06

Aprendizado por Reforço: conceitos, aplica...

Instituto de Computação - UFF

3,242 views

1:09:58

MIT Introduction to Deep Learning | 6.S191

Alexander Amini

490,448 views

17:47

Redes Neurais - Introdução às Redes Neurais

UNIVESP

5,389 views

21:58

Aprendizado de Máquinas - Conceitos Básico...

UNIVESP

24,039 views

1:14:17

Palestra - Origens da vida - Douglas Galante

UNIVESP

1,027,918 views

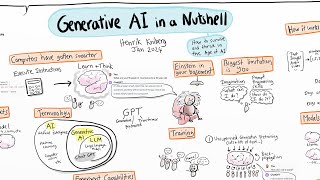

17:57

Generative AI in a Nutshell - how to survi...

Henrik Kniberg

1,889,782 views

1:02:50

MIT 6.S191 (2023): Recurrent Neural Networ...

Alexander Amini

666,290 views

26:02

Astronomia: Uma visão Geral I - Pgm 8 - As...

UNIVESP

51,898 views

58:12

MIT Introduction to Deep Learning (2023) |...

Alexander Amini

1,986,984 views

22:08

Introduction to Generative AI

Google Cloud Tech

1,756,527 views

27:13

Astronomia: Uma visão Geral I - Pgm 12 - A...

UNIVESP

43,697 views

49:43

Python Machine Learning Tutorial (Data Sci...

Programming with Mosh

2,879,171 views

21:41

How to Improve LLMs with RAG (Overview + P...

Shaw Talebi

49,369 views

3:09:08

LEARN OPENCV in 3 HOURS with Python | Incl...

Murtaza's Workshop - Robotics and AI

3,360,252 views

1:07:58

MIT 6.S191: Convolutional Neural Networks

Alexander Amini

61,231 views

19:56

Qual a diferença entre Inteligência Artifi...

Filipe Deschamps

345,799 views

26:52

Astronomia: Uma Visão Geral II - Aula 17 -...

UNIVESP

39,749 views

21:09

Types Of Machine Learning | Machine Learni...

Simplilearn

264,786 views

15:04

How I'd Learn AI (If I Had to Start Over)

Thu Vu data analytics

779,565 views